前言 仅供本人面试前准备,其他人还是别看了,没意义。有很多我缩写,省去了很多易理解的部分。

我尽量找别人已经总结过的东西,而不是自己写,无意义,面试的八股文罢了。都是靠努力就能实现的东西。

常见容器 ArrayList 详解 https://note.youdao.com/ynoteshare1/index.html?id=efd2a3a29d2626acea2b053e56bae5cc&type=notebook#/04F1A0EFF8F241C2A89E2234AAF0A36A

底层基于数组 实现

创建 ArrayList 如果不指定大小 ,会先创建一个大小为 0 的 Object[ ] 数组 ,

第一次添加数据 时,会扩容 成 ArrayList 的 默认大小 default_capacity:10** ;**

创建时如果指定大小 ,直接创建指定大小的Object[ ]数组

add()

对 size+1 ,去判断数组是否满了 ,如果满了就调用 grow()方法扩容 ,扩容大小为,原数组大小 + 原数组大小右移一位 。也就是扩容到原来的1.5倍 。JDK 1.6 是 1.5 倍 +1 ,JDK 1.7,1.8 是 1.5 倍。

然后把老数组拷贝到新数组里

elementData = Arrays.copyOf(elementData, newCapacity);

最后 elementData[ size++ ] = e ,对数组赋值,(并且size+1)

add(index,e)

首先对index做数组越界检查rangeCheck(index) ; 如果越界了,抛数组越界异常

如果没越界,还是对 size + 1,判断是否需要扩容 ,如果需要扩容,调用grow 方法

如果需要扩容,调用System.arraycopy(1,2,3,4,5) 方法。参数解释1:原来的数组,2:从哪里开始复制。3:复制的目标数组。4:目标数组的第几位开始复制。5:一共复制几个数 。

System.arraycopy(elementData, index, elementData, index + 1, size - index);

假设把数字6插入到第3位,复制过后的数组是,1 2 3 4 5 -> 1 2 3 3 4 5

然后再把目标的位置的值修改,变为 1 2 6 3 4 5

最后size++;

set(index,e)

首先解释,set这个方法是替换该位置原来的元素,所以不会使数组变大,不会做扩容判断

然后对index做数组越界检查,如果越界了,抛数组越界异常

把e替换到数组的index位置

返回数组index位置的原始值

remove(index)

首先对index做数组越界检查rangeCheck(index); ,如果越界了,抛数组越界异常

然后进行数组拷贝 System.arraycopy(elementData, index+1, elementData, index,size - index - 1);

假设把第三位数字删除,1 2 3 4 5 6 - > 1 2 4 5 6 6

然后 element[size–] = null; 最后返回被删除的值

get(index)

首先对index做数组越界检查rangeCheck(index); ,如果越界了,抛数组越界异常

return elementData(index);

总结来说,AraayList的get方法效率非常高,直接返回对应下标值,add方法和remove方法,效率就有点低了,需要考虑数组扩容和数组拷贝的问题** 。**

所以ArrayList比较适用于插入操作较少,不是很频繁插入的场景。

HashMap 详解 https://note.youdao.com/ynoteshare1/index.html?id=efd2a3a29d2626acea2b053e56bae5cc&type=notebook#/79C59785226E4D679AF124256055760B

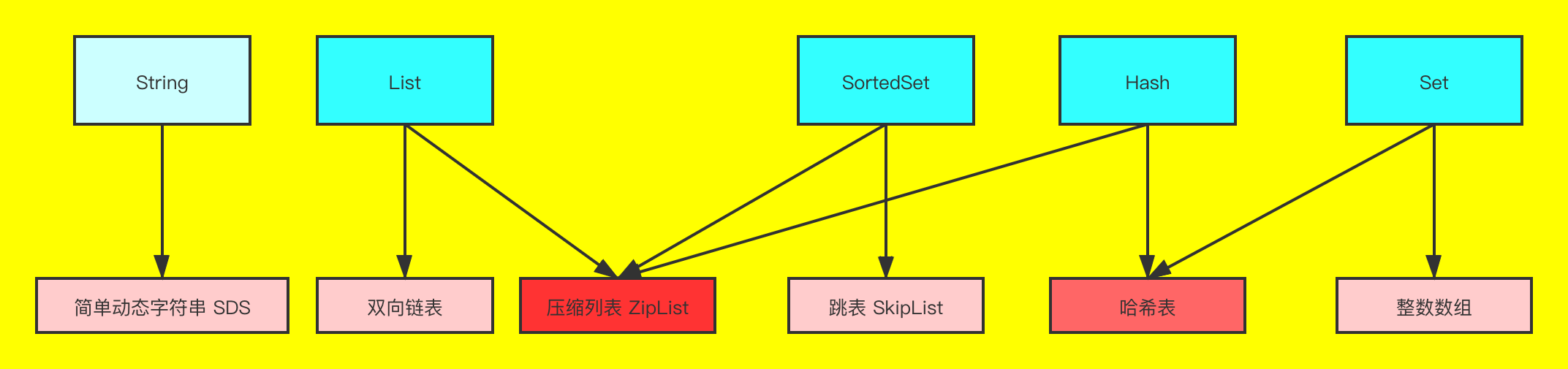

数组加单链表,1.8 后是红黑树

初始容量 16 1 << 4

加载因子 0.75 泊松分布

扩容临界值 = 容量 * 加载因子

容量必须是 2 的 n 次方,就是tableSizeFor方法

构造函数完成后也只是创建一个空数组,只有在第一次放数据时才会初始化容量,等到第一次放数据的时候用。threshold就是这个大小,构造函数阶段会算出这数的值。为什么用这个数保存数组大小,我觉得是作者觉得既然构造阶段数组没有初始化,那临界值也没什么意义,就临时当数组初始大小,等待put的时候给数组初始化,然后那时再回归他本身的意义,扩容临界值。

size是集合当前大小

构造函数三个,无参 16,一个参初始容量,两个参 初始容量和加载因子。

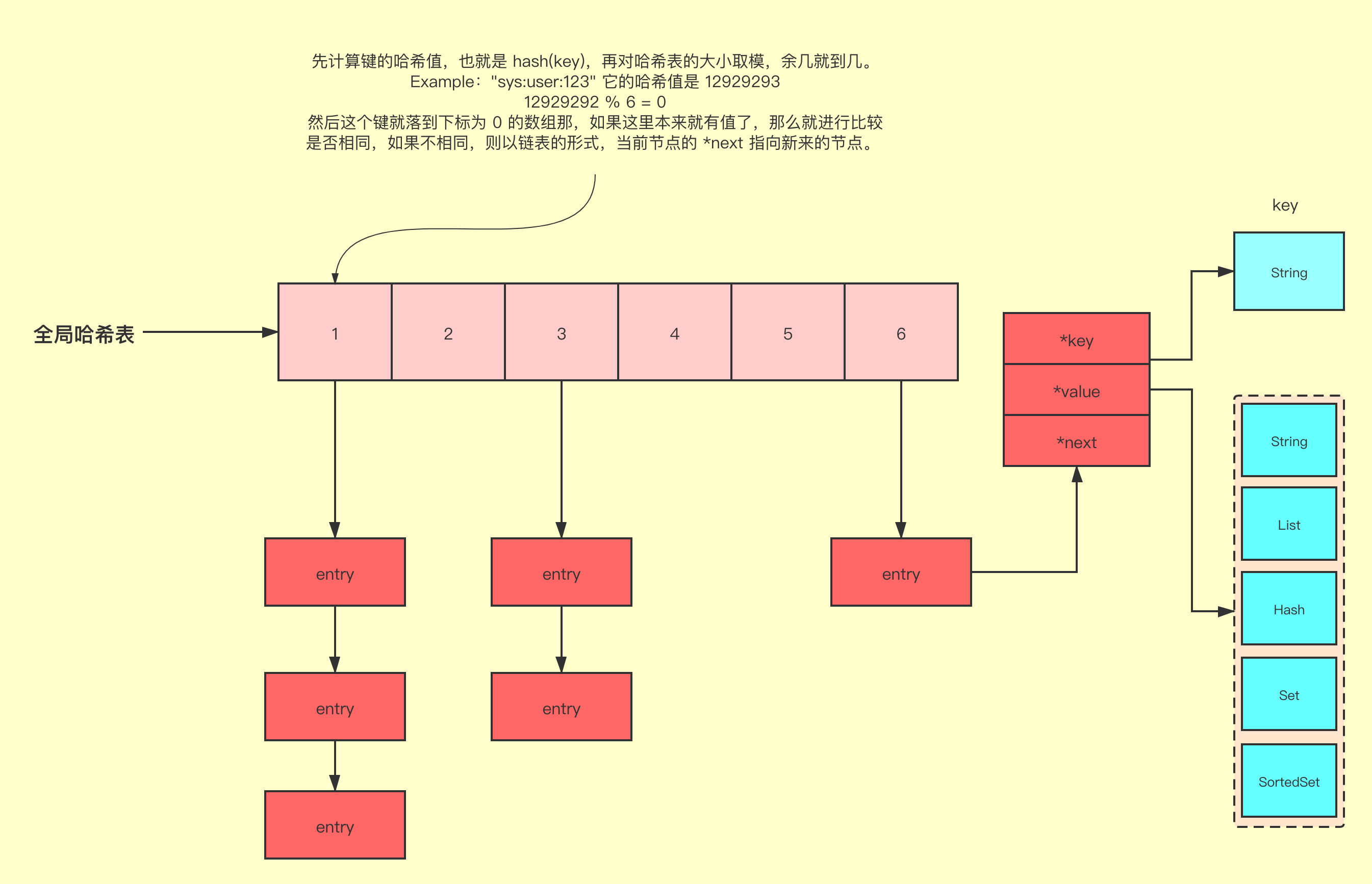

hash 算法:让高位和低位做异或运算,让高位也参与 hash 寻址运算,降低 hash 冲突。

hash 寻址:为什么是 hash 值和数组 length -1 进行与运算?取余效率低,做位运算效率高,所以容量必须是 2 的 n 次方,如果不是,就找最相近的,用 tableSizeFor 方法。

链表超过 8 个后,变红黑树(数组的容量大于等于 64)转成红黑树后,会变成 TreeNode

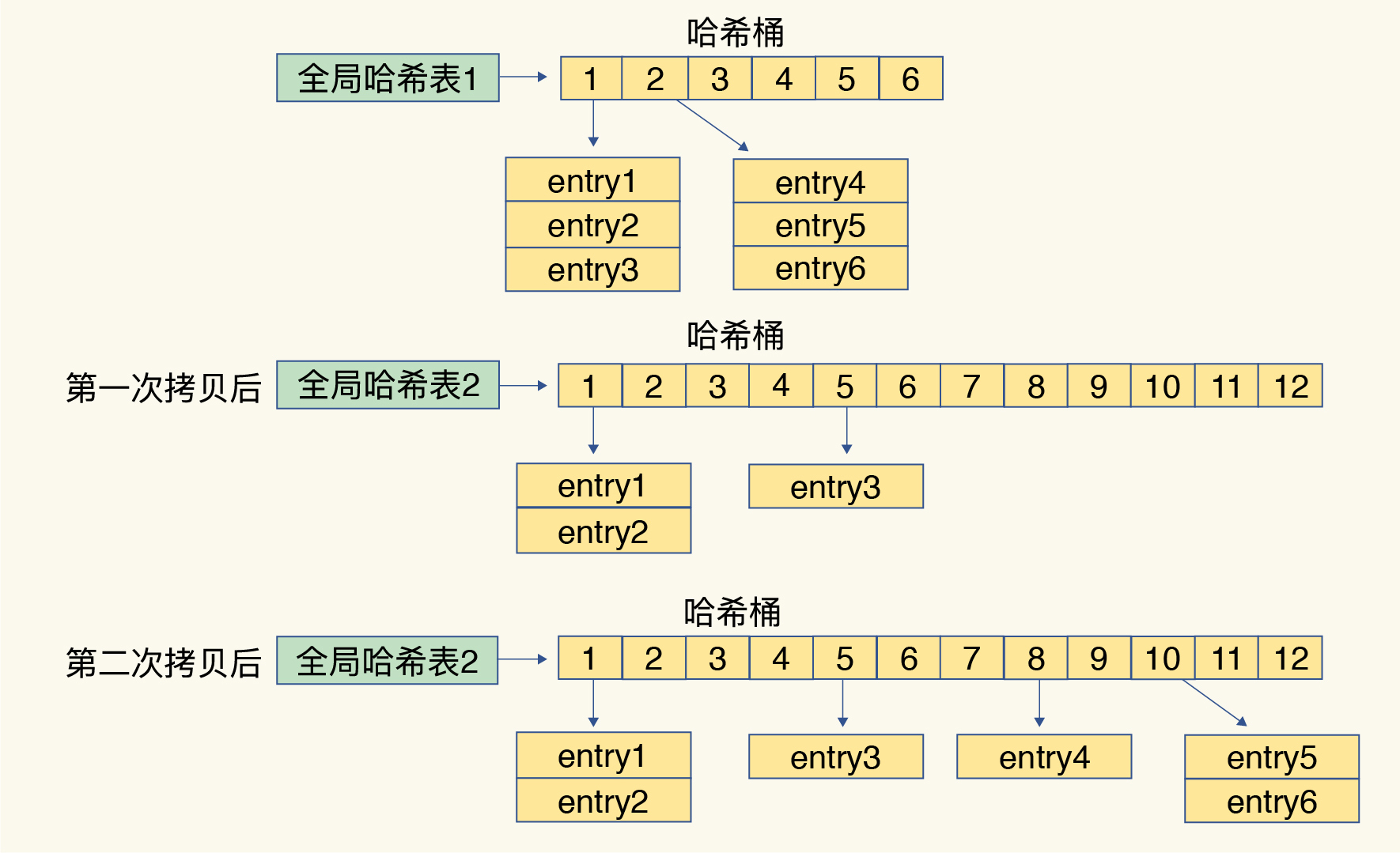

扩容机制:数组 2 倍扩容,rehash,hash & n-1,判断二进制结果中是否多出一个 bit 的1,如果没多,那么就是原来的index,如果多了出来那么就是 index+oldCap,通过这个方式,避免 rehash,用每个 hash 对新数组.length 取模,1.8 后优化了下,如果一个链表的长度超过了 8,会自动将链表转成红黑树,查找的性能是 O(logn),比 O(n)高。

红黑树是二叉查找树,左小右大,普通的二叉查找树可能出现瘸子的情况,只有一条腿,不平衡,导致查询性能变成 O(n),线性查询。红黑树有一大堆的限制条件。例如

如果破坏了红黑树的规则和平衡,会自动 rebalance,变色(红<–>黑),左旋,右旋之类的。

ps:hashcode是int型,4个字节,一个字节8个bit,一共32位

先定义个变量: key的hashcode右移 16位,其实就是把原来的hashcode值的高16位放到低16位,高16位补0。然后画图讲解:

相当于拿hashcode的低16为和高16位做异或操作(不一样的为1,一样的为0),让高16位也参与到运算中(正常来说集合的大小是不会特别大的,2的16次幂就6万多了,虽然hashmap允许的最大值是2的30次幂),所以,hash值的后16位90%的情况下都不会参与运算。但是现在高16位和低16位异或后,低16位就同时保留了高低两部分的特征,降低hash冲突。

为什么说可以降低hash冲突,因为如果两个key,解析的hashcode可能低16为一样的,但是如果这么异或一下,就不一样了

JDK 1.7 的hashMap 在并发情况下导致死循环的问题,头插法,不同线程的 next 赋值导致链表成环。不同线程,如何计算 Hash 的时候,A 线程时间片用完了,挂起,B 线程看见 table[i] 是空的,直接插入,A 线程因为已经执行完了 Hash 计算,直接进行插入,就会覆盖 B 线程插入的值

JDK 8 用 head 和 tail 来保证链表的顺序和之前一样;JDK 7 rehash 会倒置链表元素)

ConcurrentHashMap

1.7 Segment + 分段数组 + 链表

Segment 继承自 ReetrantLock

弱一致性。当创建迭代器后,其他线程删除了该元素时候并不会抛出java.util.ConcurrentModificationException异常,能够保持创建迭代器后的元素被正确的Iterator.next()出来。例如ConcurrentHashMap就是弱一致性迭代器,HashMap就是强一致性迭代器。

get 无锁,volatile 加在了 Node 上

sizeCtl -1代表有线程完成了初始化;别的负数代表有线程在扩容;初始化完成后,sizeCtl就持有下一次扩容的size,作用即threshOld

LinkedList 详解 自行查看

LinkedList 底层是基双向链表实现的

LinkedList的每条数据都会被封装成 Node

1 2 3 4 5 6 7 8 9 10 11 private static class Node <E > E item; Node<E> next; Node<E> prev; Node(Node<E> prev, E element, Node<E> next) { this .item = element; this .next = next; this .prev = prev; } }

ArrayBlockingQueue 详解 用数组实现的有界阻塞队列。此队列按照先进先出(FIFO)的原则对元素进行排序。默认情况下 不保证访问者公平的访问队列,所谓公平访问队列是指阻塞的所有生产者线程或消费者线程,当 队列可用时,可以按照阻塞的先后顺序访问队列,即先阻塞的生产者线程,可以先往队列里插入 元素,先阻塞的消费者线程,可以先从队列里获取元素。通常情况下为了保证公平性会降低吞吐 量。我们可以使用以下代码创建一个公平的阻塞队列:

1 ArrayBlockingQueue fairQueue = new ArrayBlockingQueue(1000 ,true );

LinkedBlockingQueue 详解 基于链表的阻塞队列,同 ArrayListBlockingQueue 类似,此队列按照先进先出(FIFO)的原则对 元素进行排序。而 LinkedBlockingQueue 之所以能够高效的处理并发数据,还因为其对于生产者 端和消费者端分别采用了独立的锁来控制数据同步,这也意味着在高并发的情况下生产者和消费 者可以并行地操作队列中的数据,以此来提高整个队列的并发性能。

LinkedBlockingQueue 会默认一个类似无限大小的容量(Integer.MAX_VALUE)。

ConcurrentHashMap详解 1.7分段数组+单向链表

1.8其中抛弃了原有的 Segment 分段锁,而采用了 CAS + synchronized 来保证并发安全性。

https://www.jianshu.com/p/aa017a3ddc40

枚举 从字节码层面上看,枚举仅仅是一个继承于 java.lang.Enum 的类、自动生成了 values 和 valueOf 方法的普通 Java 类而已。

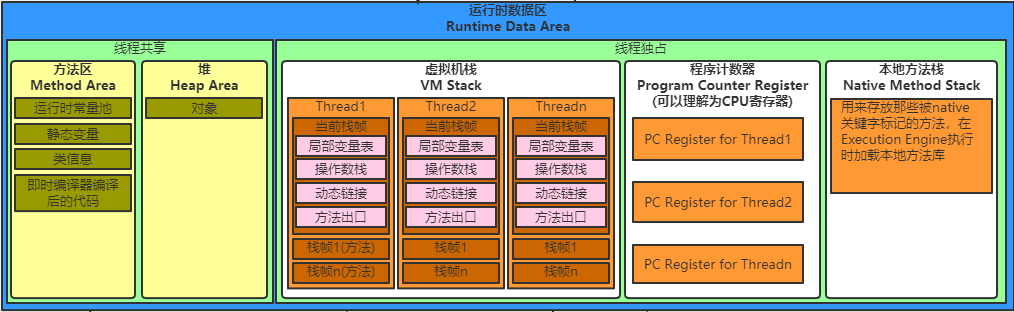

CopyOnWriteArrayList IO NIO Reflect Class Method Constructor ClassLoader JVM 运行时数据区 // 不想自己画,原图片在 https://www.cnblogs.com/wuzhenzhao/p/12346515.html

程序计数器 程序计数器是一块较小的内存空间,它可以看作是当前线程所执行的字节码的行号指示器。在虚拟机的概念模型里面(仅是概念模型,各种虚拟机可能会通过一些更高效的方式去实现),字节码解释工作时就是通过改变这个计数器的值来选去下一条需要执行的字节码指令,分支、循环、跳转、异常处理、线程回复等基础功能都需要以来这个计数器来完成。

Java 虚拟机栈 与程序计数器一样,Java虚拟机栈也是线程私有的,它的生命周期与线程相同。虚拟机描述的是Java方法执行的内存模型:每个方法在执行的同时都会创建一个栈帧(Stack Frame)用于存储局部变量表、操作数栈、动态链接、方法出口等信息。每一个方法从调用直至执行完成的过程,就对应着一个栈帧在虚拟机栈中入栈到出栈的过程。

Java虚拟机栈中还有着局部变量表部分,局部变量表存放了编译期可知的各种基本数据类型(boolean、byte、char、short、int、float、long、doublle)、对象引用(reference类型,它不等同于对象本身,可能是一个指向对象起始地址的引用指针,也可能是指向一个代表对象的句柄或其他与此对象相关的位置)和 returnAddress 类型(指向了一条字节码指令的地址)。

其中 64 位长度的 long 和 double 类型的数据会占用 2 个局部变量空间(Slot),其余的数据类型只占用1个。局部变量表所需要的内存空间是完全确定的,在方法运行期间不会改变局部变量表的大小。

在 Java 虚拟机规范中,对这个区域规定了两种异常状况:如果线程请求的栈深度大于虚拟机所允许的深度,将抛出 StackOverflowError 异常;如果虚拟机栈可以动态扩展(当前大部分的Java虚拟机都可动态扩展,只不过 Java 虚拟机规范中也允许固定长度的虚拟机栈)如果扩展是无法申请到足够的内存,就会抛出OOME异常。OutOfMemoryError 后文就简称为 OOME 了。

本地方法栈 本地方法栈(Native Method Stack)与虚拟机栈所发挥的作用是非常相似的,它们之间的区别不过是虚拟机栈为虚拟机执行Java方法(也就是字节码)服务,而本地方法栈则为虚拟机使用到的 Native 方法服务。在虚拟机规范中对本地方法栈中方法使用的语言、使用方式与数据结构并没有强制规定,因此具体的虚拟机可以自由的实现它。甚至有的虚拟机(譬如Sun HotSpot虚拟机)直接就把本地方法栈和虚拟机栈合二为一。与虚拟机栈一样,本地方法栈区域也会抛出 StackOverflowError 和 OOME 异常。

堆 Java 堆是被所有线程共享的一块内存区域,在虚拟机启动时创建。此内存区域的唯一目的就是存放对象实例,几乎所有的对象实例都在这里分配内存。这一点Java虚拟机规范的描述是:所有的对象实例以及数组都要在堆上分配,JIT,逃逸分析,栈上创建对象。

分代回收,新生代(from+to+Eden,1:1:8)+老年代。从内存分配的角度来看,线程共享Java堆中可能划分出多个线程私有的分配缓冲区。

逻辑上连续内存空间。

方法区(Method Area)与 Java 堆一样,是各个线程共享的内存区域,它用于存储已被虚拟机加载的类信息、常量、静态变量、即使编译器后的代码等数据。又名非堆(Non-Heap),1.7 用永久代(Permanent Generation)实现方法区,1.8 更名为 Meta Space。1.7 及以前的版本的项目容易报 Permanent Generation OOM,1.6 默认 82M,1.7 默认 128M,当类和静态变量一多就容易报错,解决办法是加大这块内存地址。

运行时常量池 运行时常量池(Runtime Pool)是方法区的一部分。Class文件中除了有类的版本,字段,方法,接口等描述信息外,还有一项信息是常量池(Constant Pool Table),用于存放编译期生成的各种字面量和符号引用,这部分内容将在类加载后进入方法区的运行时常量池中存放。

运行时常量是相对于常量来说的,它具备一个重要特征是:动态性。当然,值相同的动态常量与我们通常说的常量只是来源不同,但是都是储存在池内同一块内存区域。Java语言并不要求常量一定只能在编译期产生,运行期间也可能产生新的常量,这些常量被放在运行时常量池中。这里所说的常量包括:基本类型包装类(包装类不管理浮点型,整形只会管理-128到127)和String(也可以通过String.intern()方法可以强制将String放入常量池)。

直接内存 直接内存(Direct Memory)并不是虚拟机运行时数据区的一部分,也不是Java虚拟机规范定义中的内存区域。但那是这部分内存也被频繁地使用,而且也可能异常能导致OOME异常出现,

对象创建

指针碰撞 :假设 Java 堆中内存是绝对规整的,所有内存都放在一遍,空闲的内存放在另一边,中间放一个指针作为分解点的指示器,那所分配内存仅仅是把那个指针向空闲空间那边挪一段与对象大小相等的距离。空闲列表 :因为堆内存在物理上是不连续的,而在逻辑上是连续的。当虚拟机在给对象在堆中分配内存时,会出现不是在连续内存空间上分配的情况。为了让对象能够在堆中能分到内存,虚拟机必须维护一个列表,记录上哪些内存块是可以用的,在分配的时候从列表中找到一块足够大的空间划分给对象实例,并更新列表上的记录。

什么情况会发生 OOM

堆溢出

虚拟机栈和本地方法栈溢出—— 1.请求的栈深度大于虚拟机允许的最大深度,抛出 StackOverflowError。2. 如果虚拟机在扩展栈时无法申请到足够的内存空间,则抛出 OOM。

方法区和运行时常量池溢出——常量池属于方法区的一部分,类太多(包括本身就有的,还有动态生成的类太多)。

本机直接内存溢出—— -XX:MaxDirectMemorySize 指定,不指定,默认和 Java 堆最大值( -Xmx 指定) 一样。

什么时候回收对象 引用计数 你引用我,我引用你,你我都是空对象。就会导致这个引用计数回收不了, Python 就是用的引用计数。

可达性分析算法 GC Roots

虚拟机栈(栈帧中的本地变量表)中引用的对象。

方法区中类静态属性引用的对象。

方法区中常量引用的对象。

本地方法栈中 JNI 应用的对象。

什么时候对象不可达? 第一次标记

第二次标记

经过第一次标记后的对象,根据 此对象是否有必要执行finalize()方法 进行筛选。被判定为确实有必要执行finalize()方法的对象将会被放置在一个名为F-Queue的队列之中。

GC 算法 标记清除(Mark-Sweep) 分为两个阶段,标注和清除。标记阶段标记出所有需要回收的对象,清 除阶段回收被标记的对象所占用的空间,容易产生内存碎片。

复制(copying) 按内存容量将内存划分为等大小的两块。每次只使用其中一块,当这一块内存满后将尚存活的对象复制到另一块上去,把已使用的内存清掉。消耗内存多,但是没有内存碎片产生,用于新生代对象创建。

标记整理(Mark-Compact) 标记后不是清理对象,而是将存活对象移向内存的一端,然后清除端边界外的对象。

和指针碰撞不同

分代收集算法 根据对象存活的不同生命周期将内存划分为不同的域,一般情况下将 GC 堆划分为老生代(Tenured/Old Generation)和新生代(Young Generation)。老生代的特点是每次垃圾回收时只有少量对象需要被回收,新生代的特点是每次垃 圾回收时都有大量垃圾需要被回收,因此可以根据不同区域选择不同的算法。

新生代与复制算法 目前大部分 JVM 的 GC 对于新生代都采取 Copying 算法,因为新生代中每次垃圾回收都要 回收大部分对象,即要复制的操作比较少,但通常并不是按照 1:1 来划分新生代。一般将新生代 划分为一块较大的 Eden 空间和两个较小的 Survivor 空间(From Space, To Space),每次使用 Eden 空间和其中的一块 Survivor 空间,当进行回收时,将该两块空间中还存活的对象复制到另 一块 Survivor 空间中。

老年代与标记复制算法 而老年代因为每次只回收少量对象,因而采用 Mark-Compact 算法。

JAVA 虚拟机提到过的处于方法区的永生代(Permanet Generation),它用来存储 class 类, 常量,方法描述等。对永生代的回收主要包括废弃常量和无用的类。

对象的内存分配主要在新生代的 Eden Space 和 Survivor Space 的 From Space(Survivor 目 前存放对象的那一块),少数情况会直接分配到老生代。

当新生代的 Eden Space 和 From Space 空间不足时就会发生一次 GC,进行 GC 后,Eden Space 和 From Space 区的存活对象会被挪到 To Space,然后将 Eden Space 和 From Space 进行清理。

如果 To Space 无法足够存储某个对象,则将这个对象存储到老生代。

在进行 GC 后,使用的便是 Eden Space 和 To Space 了,如此反复循环。

当对象在 Survivor 区躲过一次 GC 后,其年龄就会+1。默认情况下年龄到达 15 的对象会被 移到老生代中。

Java 四中引用类型 强引用 把一个对象赋给一个引用变量,这个引用变量就是一个强引 用。当一个对象被强引用变量引用时

软引用 软引用需要用 SoftReference 类来实现,对于只有软引用的对象来说,当系统内存足够时它 不会被回收,当系统内存空间不足时它会被回收。软引用通常用在对内存敏感的程序中。

弱引用 弱引用需要用 WeakReference 类来实现,它比软引用的生存期更短,对于只有弱引用的对象 来说,只要垃圾回收机制一运行,不管 JVM 的内存空间是否足够,总会回收该对象占用的内存。

虚引用 虚引用需要 PhantomReference 类来实现,它不能单独使用,必须和引用队列联合使用。虚 引用的主要作用是跟踪对象被垃圾回收的状态。

什么是 Safepoint Safepoint 可以用在不同地方,比如GC、Deoptimization,在Hotspot VM中,GC safepoint比较常见,需要一个数据结构记录每个线程的调用栈、寄存器等一些重要的数据区域里什么地方包含了GC管理的指针。

从线程角度看,safepoint可以理解成是在代码执行过程中的一些特殊位置,当线程执行到这些位置的时候,说明虚拟机当前的状态是安全的,如果有需要,可以在这个位置暂停,比如发生GC时,需要暂停暂停所以活动线程,但是线程在这个时刻,还没有执行到一个安全点,所以该线程应该继续执行,到达下一个安全点的时候暂停,等待GC结束。

https://www.jianshu.com/p/c79c5e02ebe6

Minor GC 和 Full GC 的触发机制 新生代 GC(Minor GC) 指发生在新生代的垃圾收集动作,因为 Java 对象大多都具备朝生夕灭的特性,所以 Minor GC 非常频繁,一般回收速度也比较快。

老年代 GC(Major GC/Full GC) 指发生在老年代的 GC,出现了 Major GC,经常会伴随着至少一次的 Minor GC(但非绝对的,在 Parallel Scavenge 收集器的收集策略里就有直接进行 Major GC 的策略选择过程)。Major GC 的速度一般会比 Minor GC 慢 10 倍以上。

JVM 系列文章之 Full GC 和 Minor GC

设置参数,可让创建对象时,直接进入old区。

如果对象在 Eden 区出生并经过第一次 Minor GC 后仍然存活,并且能够被 Surviror 容纳的话,将被一定到 Survivor 空间中,并且对象年龄设为 1。对象在 Survivor 中每“熬”过一次 Minor GC,年龄+1,默认到 15 就晋升到老年代。但并不是永远要求对象年龄必须达到那个参数,如果在 Survivor 空间中相同年龄所有对象的大小的总和大于 Survivor 空间的一半,年龄大于或等于该年龄的对象就可以直接进入老年代。

-XX:MaxTenuringThreshold=15 CMS里面默认是6。

内存分配以及回收 对象优先在 Eden 区分配 大多数情况下,对象优先在 Eden 区中分配。当 Eden 区没有足够空间进行分配时,虚拟机将发起一次 Minor GC。

大对象为什么直接进入老年代 虚拟机提供了一个-XX:PretenureSizeThreshold参数,不同垃圾收集器默认值不同,直接在 Eden 区。大于这个设置值的对象直接在老年代分配。这样做的目的是避免在Eden区及两个Survivor区(from区to区)之间发生大量的内存复制。不同分代,采用不同垃圾回收算法,young 区采用的是复制清除算法,如果是大对象,就得不偿失了。

注意:PretenureSizeThreshold参数只对Serial和ParNew两款收集器有效,Parallel Scavenge收集器不认识这个参数,Parallel Scavenge收集器一般并不需要设置。如果遇到必须使用此参数的场合,可以考虑ParNew加CMS的收集器组合。

一个简单的方法,在 Spring Boot项目中写个 循环依赖类(需要特殊处理,在我的 github 上的一个项目中有),然后用 类层次 类去引用,再Debug,就能看见 栈溢出信息,和 from to区的信息。

空间分配担保 在发生 Minor GC 之前,虚拟机会先检查老年代最大可用的连续空间是否大于新生代所有对象总空间,如果是,Minor GC 确保安全。看 HandlePromotionFailure 是否允许担保失败。如果允许,会继续检查老年代最大可用的连续空间是否大于历次晋升到老年代对象的平均大小,如果大于,将尝试进行一次 Minor GC,尽管这次 Minor GC 有风险,如果小于或者配置的不允许,那么就改成一次 Full GC。

JVM 调优

-Xms -Xmx 设置成一样 。例如 -Xms2048M -Xmx2048M

-XX:USEBAISEDLOCKED=FALSE 关闭偏向锁。JDK 1.6引入新概念,在线程竞争不激烈时引入,偏向锁,轻量级锁。支持锁的升级和降级,但并发比较大的环境下,关掉这个是好的选择。在对象头中标出,00,01,10,11,两位标出是什么状态。

年轻代:-XX:+UseParNewGC。

老年代:-XX:+UseConcMarkSweepGC。

-XX:-DoEscapeAnalysis : 表示关闭逃逸分析 从jdk 1.7开始已经默认开始逃逸分析,如需关闭,需要指定-XX:-DoEscapeAnalysis。逃逸分析是让某些朝生夕死的对象,在栈上创建对象,随着栈的消亡而消亡。

https://www.hollischuang.com/archives/2583

频繁触发 Full GC ,如果使用的是 G1,可以加上 -XX:+PrintAdaptiveSizePolicy 参数,查看到底是谁引发的

更多见 https://www.oracle.com/technetwork/tutorials/tutorials-1876574.html。比如你用的是 Azkaban,这种朝生夕死的任务执行的项目,它默认的配置是很简单的,也是很坑的。我的建议是把下面的调整到 5、5。当然,这个我也只是简单测了,改成这样后,就没有之前的 OOM 问题了。更好的比例,需要你一遍遍调。

-XX:NewRatio=n

Ratio of new/old generation sizes. The default value is 2.

-XX:SurvivorRatio=n

Ratio of eden/survivor space size. The default value is 8.

类加载 加载过程

https://www.cnblogs.com/straybirds/p/8513870.html

什么时候加载,虚拟机规范没强制要求,这点虚拟机自己发挥,但是初始化阶段,虚拟机规范严格规定了有且仅有 5 种情况必须立即对类进行初始化。

遇到 new、getstatic、putstatic 或 invokestatic 这 4 条字节码指令时。new 对象,读取或者设置一个类的静态字段(非 final 修饰、已在编译期把结果放入常量池的静态字段除外)的时候,调用静态方法的时候。

使用 java.lang.reflect 包的方法对类进行反射调用的时候。没有初始化,则要。

当初始化一个类的时候,如果其父类未被初始化,则需要先触发其父类的初始化。

当虚拟机启动时,用户需要指定一个需要执行的主类。(main 方法)

当使用 JDK 1.7 的动态语言支持时,如果一个 java.lang.invoke.MethodHandle 实例最后的解析结果 REF_getStatic、REF_putStatic、REF_invokeStatic 的方法句柄,并且这个方法的句柄所对应的类没有进行过初始化,则需要先出发其初始化。

双亲委派模型

Bootstrap ClassLoader(C++ 实现,负责将存放在 <JAVA_HOME>\lib目录中的,或者被 -Xbootclasspath 参数所指定的路径中的,并且是虚拟机识别的仅按照文件名识别,例如 rt.jar 名字不符合也不会加载。加载到虚拟机的内存中。返回 null 就能用这个加载器加载)

Extension ClassLoader(Java 实现负责加载 <JAVA_HOME>\lib\ext目录中的,或者被 java.ext.dirs 系统变量所指定的路径中的所有类库,开发者可以直接用)

Application ClassLoader(Java 实现 一般情况下,这个就是默认的类加载器)

自定义 ClassLoader

破坏双委派模型 自己覆盖 loadClass 。OSGi 给“高速奔跑的汽车换轮胎”。还有公司要求会这个。。。。

虚拟机字节码执行引擎

局部变量表

动态连接

方法返回地址

操作数栈

方法调用

解析

分派

动态类型语言支持

这个就是方法调用就是压栈,舍弃当前栈帧就是返回上一个方法。Debug 的 drop frame。

程序源码 -> 语法解析 -> 单词流 -> 语法解析 -> 抽象语法树

二选一

-> 指令流 -> 解释器 -> 解释执行

-> 优化器 -> 中间代码 -> 生成器 -> 目标代码

JVM 各种优化 编译优化 例如

1 2 3 4 String a = "Foo" + "Bar" ; String b = "FooBar" ; System.out.println(a == b);

运行优化

JMM https://zhuanlan.zhihu.com/p/29881777

无非就是搞了个抽象,具体实现,不同虚拟机不同的来。

多线程 volatile 如何保证内存可见性 volatile 是 Java 提供的轻量级同步机制

MESI 协议 MESI 协议 是一个基于失效的缓存一致性 协议,是支持回写(write-back)缓存的最常用协议。也称作伊利诺伊协议 (Illinois protocol,因为是在伊利诺伊大学厄巴纳-香槟分校 被发明的[1] )。与写通过(write through)缓存相比,回写缓冲能节约大量带宽。总是有“脏”(dirty)状态表示缓存中的数据与主存中不同。MESI协议要求在缓存不命中(miss)且数据块在另一个缓存时,允许缓存到缓存的数据复制。与MSI协议 相比,MESI协议减少了主存的事务数量。这极大改善了性能。[2]

JMM(Java Memory Model)本身是一种抽象的概念,并不真实存在,它描述的一组规则或规范,通过这组规范定义了程序中各个变量(含实例字段,静态字段和构成数组对象的元素)的访问方式。

JMM关于同步的规定:

线程解锁前必须把共享变量的值刷新回主存

线程加锁前,必须读取主存的最新值到自己的工作内存

加锁解锁是同一把锁

更多https://blog.csdn.net/t894690230/article/details/50588129

happens-before

程序次序法则:如果在程序中,所有动作 A 出现在动作 B 之前,则线程中的每动作 A 都 happens-before 于该线程中的每一个动作 B。

监视器锁法则:对一个监视器的解锁 happens-before 于每个后续对同一监视器的加锁。

volatile 变量法则:对 volatile 域的写入操作 happens-before 于每个后续对同一 volatile 的读操作。

传递性:如果 A happens-before 于 B,且 B happens-before C,则 A happens-before C。

https://juejin.im/post/5ae6d309518825673123fd0e

https://en.wikipedia.org/wiki/Happened-before

Synchronized C++ 实现源码解析 自旋锁的定义:当一个线程尝试去获取某一把锁的时候,如果这个锁此时已经被别人获取(占用),那么此线程就无法获取到这把锁,该线程将会等待,间隔一段时间后会再次尝试获取。这种采用循环加锁 -> 等待的机制被称为自旋锁(spinlock)。

因为自旋锁避免了操作系统进程调度和线程切换,所以自旋锁通常适用在时间比较短的情况下。由于这个原因,操作系统的内核经常使用自旋锁。但是,如果长时间上锁的话,自旋锁会非常耗费性能,它阻止了其他线程的运行和调度。线程持有锁的时间越长,则持有该锁的线程将被 OS(Operating System) 调度程序中断的风险越大。如果发生中断情况,那么其他线程将保持旋转状态(反复尝试获取锁),而持有该锁的线程并不打算释放锁,这样导致的是结果是无限期推迟,直到持有锁的线程可以完成并释放它为止。

解决上面这种情况一个很好的方式是给自旋锁设定一个自旋时间,等时间一到立即释放自旋锁。自旋锁的目的是占着CPU资源不进行释放,等到获取锁立即进行处理。但是如何去选择自旋时间呢?如果自旋执行时间太长,会有大量的线程处于自旋状态占用 CPU 资源,进而会影响整体系统的性能。因此自旋的周期选的额外重要!JDK在1.6 引入了适应性自旋锁,适应性自旋锁意味着自旋时间不是固定的了,而是由前一次在同一个锁上的自旋时间以及锁拥有的状态来决定,基本认为一个线程上下文切换的时间是最佳的一个时间。

synchronized.cpp解析

Jdk1.6 锁的升级与降级,自旋锁->偏向锁->轻量级锁->重量级锁(操作系统内核的 mutex lock)

ReentrantLock 和 synchronized 之间 在加锁和内存上提供的语义与内置锁相同,此外它还提供了可定时、可中断、可轮询、公平性,以及实现非块结构的加锁。只要在需要这些高级的功能时,用 ReentrantLock,否则还是应该优先使用 synchronized。

ThreadLocal https://github.com/Snailclimb/JavaGuide/blob/master/docs/java/Multithread/ThreadLocal.md

Spring MVC 中,RequestHolder 使用 ThreadLocal 进行 HttpServletRequest 进行缓存。还有事务,AopProxyHolder、MyBatis 的 PageHelper 这种,都是根据当前线程的变量来确定的。

AQS https://github.com/Snailclimb/JavaGuide/blob/master/docs/java/Multithread/AQS.md

Doug Lea 设计的,CountDownLatch、ReentrantLock 都继承这个类,是 Java 最低层级的同步机制。

AQS 是一个用来构建锁和同步器的框架,使用 AQS 能简单且高效地构造出应用广泛的大量的同步器。

AQS 原理概览 AQS 核心思想是,如果被请求的共享资源空闲,则将当前请求资源的线程设置为有效的工作线程,并且将共享资源设置为锁定状态。如果被请求的共享资源被占用,那么就需要一套线程阻塞等待以及被唤醒时锁分配的机制,这个机制 AQS 是用 CLH 队列锁实现的,即将暂时获取不到锁的线程加入到队列中。

volatile 变量 + 双向队列。

AQS 对资源的共享方式

Exclusive(独占)

只有一个线程能执行,如 ReentrantLock。又可分为公平锁和非公平锁,ReentrantLock 同时支持两种锁,下面以 ReentrantLock 对这两种锁的定义做介绍:

公平锁:按照线程在队列中的排队顺序,先到者先拿到锁

非公平锁:当线程要获取锁时,先通过两次 CAS 操作去抢锁,如果没抢到,当前线程再加入到队列中等待唤醒。

Share(共享)

多个线程可同时执行,如 Semaphore/CountDownLatch。Semaphore、CountDownLatCh、 CyclicBarrier、ReadWriteLock 我们都会在后面讲到。

ReentrantReadWriteLock 可以看成是组合式,因为 ReentrantReadWriteLock 也就是读写锁允许多个线程同时对某一资源进行读。

不同的自定义同步器争用共享资源的方式也不同。自定义同步器在实现时只需要实现共享资源 state 的获取与释放方式即可,至于具体线程等待队列的维护(如获取资源失败入队/唤醒出队等),AQS 已经在上层已经帮我们实现好了。

Fork/Join https://time.geekbang.org/column/article/92524

Fork/Join 是一个并行计算的框架,主要就是用来支持分治任务模型的,这个计算框架里的 Fork 对应的是分治任务模型里的任务分解,Join 对应的是结果合并。Fork/Join 计算框架主要包含两部分,一部分是分治任务的线程池 ForkJoinPool,另一部分是分治任务 ForkJoinTask。这两部分的关系类似于 ThreadPoolExecutor 和 Runnable 的关系,都可以理解为提交任务到线程池,只不过分治任务有自己独特类型 ForkJoinTask。

ForkJoinTask 是一个抽象类,它的方法有很多,最核心的是 fork() 方法和 join() 方法,其中 fork() 方法会异步地执行一个子任务,而 join() 方法则会阻塞当前线程来等待子任务的执行结果。ForkJoinTask 有两个子类——RecursiveAction 和 RecursiveTask,通过名字你就应该能知道,它们都是用递归的方式来处理分治任务的。这两个子类都定义了抽象方法 compute(),不过区别是 RecursiveAction 定义的 compute() 没有返回值,而 RecursiveTask 定义的 compute() 方法是有返回值的。这两个子类也是抽象类,在使用的时候,需要你定义子类去扩展。

Fork/Join 并行计算的核心组件是 ForkJoinPool。ForkJoinPool 本质上也是一个生产者 - 消费者的实现,但是更加智。ThreadPoolExecutor 内部只有一个任务队列,而 ForkJoinPool 内部有多个任务队列,当我们通过 ForkJoinPool 的 invoke() 或者 submit() 方法提交任务时,ForkJoinPool 根据一定的路由规则把任务提交到一个任务队列中,如果任务在执行过程中会创建出子任务,那么子任务会提交到工作线程对应的任务队列中。

如果工作线程对应的任务队列空了,是不是就没活儿干了呢?不是的,ForkJoinPool 支持一种叫做“任务窃取”的机制,如果工作线程空闲了,那它可以“窃取”其他工作任务队列里的任务,例如下图中,线程 T2 对应的任务队列已经空了,它可以“窃取”线程 T1 对应的任务队列的任务。如此一来,所有的工作线程都不会闲下来了。ForkJoinPool 中的任务队列采用的是双端队列,工作线程正常获取任务和“窃取任务”分别是从任务队列不同的端消费,这样能避免很多不必要的数据竞争。我们这里介绍的仅仅是简化后的原理,ForkJoinPool 的实现远比我们这里介绍的复杂

Fork/Join 并行计算框架主要解决的是分治任务。分治的核心思想是“分而治之”:将一个大的任务拆分成小的子任务去解决,然后再把子任务的结果聚合起来从而得到最终结果。这个过程非常类似于大数据处理中的 MapReduce,所以你可以把 Fork/Join 看作单机版的 MapReduce。

Fork/Join 并行计算框架的核心组件是 ForkJoinPool。ForkJoinPool 支持任务窃取机制,能够让所有线程的工作量基本均衡,不会出现有的线程很忙,而有的线程很闲的状况,所以性能很好。Java 1.8 提供的 Stream API 里面并行流也是以 ForkJoinPool 为基础的。不过需要你注意的是,默认情况下所有的并行流计算都共享一个 ForkJoinPool,这个共享的 ForkJoinPool 默认的线程数是 CPU 的核数;如果所有的并行流计算都是 CPU 密集型计算的话,完全没有问题,但是如果存在 I/O 密集型的并行流计算,那么很可能会因为一个很慢的 I/O 计算而拖慢整个系统的性能。所以建议用不同的 ForkJoinPool 执行不同类型的计算任务。

死锁 一组互相竞争资源的线程因互相等待,导致“永久”阻塞的现象。线程 A 有🔒 1,我还想获取🔒 2,但是另一个线程 B 持有🔒 2,两个线程都不释放锁,等着对方释放锁,就会导致死锁。一般死锁了,只能重启。

死锁发生的条件

互斥,共享资源 X 和 Y 只能被一个线程占用;

占有且等待,线程 T1 已经取得共享资源 X,在等待共享资源 Y 的时候,不释放共享资源 X;

不可抢占,其他线程不能强行抢占线程 T1 占有的资源;

循环等待,线程 T1 等待线程 T2 占有的资源,线程 T2 等待线程 T1 占有的资源,就是循环等待。

破坏其中一个,就可以成功避免死锁的发生。

CAS 全称是 Compare And Swap,即“比较并交换。

CAS 指令包含 3 个参数:共享变量的内存地址 A、用于比较的值 B 和共享变量的新值 C;并且只有当内存中地址 A 处的值等于 B 时,才能将内存中地址 A 处的值更新为新值 C。作为一条 CPU 指令,CAS 指令本身是能够保证原子性的。

ABA 问题,加版本号。

AtomicInteger 调用 Unsafe 的 compareAndSwap native 方法 1 2 3 public final boolean compareAndSet (int expect, int update) return unsafe.compareAndSwapInt(this , valueOffset, expect, update); }

native 方法 compareAndSwapInt 在 Linux 下的 JDK 实现如下。 1 2 3 4 5 6 UNSAFE_ENTRY(jboolean, Unsafe_CompareAndSwapInt(JNIEnv *env, jobject unsafe, jobject obj, jlong offset, jint e, jint x)) UnsafeWrapper("Unsafe_CompareAndSwapInt" ); oop p = JNIHandles::resolve(obj); jint* addr = (jint *) index_oop_from_field_offset_long(p, offset); return (jint)(Atomic::cmpxchg(x, addr, e)) == e; UNSAFE_END

Atocmic::cmpxchg 在 x86 处理器架构下(Linux 下)的 JDK 实现 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 > What I'm a bit uncertain about here is which barriers we need and which are optimal as it seems to be a bit different for different ARM versions, maybe somebody can enlighten me? Also I'm not sure how hotspot checks ARM version to make the appropriate decision. > > The proposed x86 implementation is much more straight forward (bsd, linux): > > inline jbyte Atomic::cmpxchg(jbyte exchange_value, volatile jbyte* dest, jbyte compare_value) { > int mp = os::is_MP(); > jbyte result; > __asm__ volatile (LOCK_IF_MP(%4) "cmpxchgb %1,(%3)" > : "=a" (result) > : "q" (exchange_value), "a" (compare_value), "r" (dest), "r" (mp) > : "cc", "memory"); > return result; > } > >>> The implementation of single byte Atomic::cmpxchg on x86 (and all other >>> platforms) emulates the single byte cmpxchgb instruction using a loop of >>> jint-sized load and cmpxchgl and code to dynamically align the destination >>> address. >>> >>> This code is used for GC-code related to remembered sets currently. >>> >>> I have the changes on my platform (amd64, bsd) to simply use the native >>> cmpxchgb instead but could provide a patch fixing this unnecessary >>> performance glitch for all supported x86 if anybody wants this? >> >> I think that sounds good. >> Would you mind looking at other cpu arches to see if they provide something >> similar? It's ok if you can't build the code for the other arches, I can help >> you with that. >> >> /Mikael

ThreadPoolExecutor 配置 ThreadPoolExecutor 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 public ThreadPoolExecutor (int corePoolSize, int maximumPoolSize, long keepAliveTime, TimeUnit unit, BlockingQueue<Runnable> workQueue, ThreadFactory threadFactory, RejectedExecutionHandler handler) if (corePoolSize < 0 || maximumPoolSize <= 0 || maximumPoolSize < corePoolSize || keepAliveTime < 0 ) throw new IllegalArgumentException(); if (workQueue == null || threadFactory == null || handler == null ) throw new NullPointerException(); this .acc = System.getSecurityManager() == null ? null : AccessController.getContext(); this .corePoolSize = corePoolSize; this .maximumPoolSize = maximumPoolSize; this .workQueue = workQueue; this .keepAliveTime = unit.toNanos(keepAliveTime); this .threadFactory = threadFactory; this .handler = handler; }

corePoolSize —— 线程池的目标大小,即在没有任务执行时线程池的大小,并且只有在工作队列满了的情况下才会创建超过这个数量的线程。在 ThreadPoolExecutor 初期,线程并不会立即启动,而是等到有任务提交时才会启动,除非调用 prestartAllThreads。

maximumPoolSize —— 线程池最大值。 the maximum number of threads to allow in the pool。

keepAliveTime —— 当线程数超过核心线程数时,这是多余的空闲线程将在终止之前等待新任务的最长时间。 when the number of threads is greater than the core, this is the maximum time that excess idle threads will wait for new tasks before terminating.

unit —— 上面的时间单位the time unit for the {@code keepAliveTime} argument

workQueue —— 任务队列,这个是提交的任务队列,如果提交的任务大于最大线程数了,会优先放到这个任务队列中。 the queue to use for holding tasks before they are executed. This queue will hold only the {@code Runnable} tasks submitted by the {@code execute} method.

threadFactory —— 利用 ThreadFactory#newThread 来创建 Thread,这里可以对 Thread 进行命名。the factory to use when the executor creates a new thread.

handler —— 执行不了了,wokerqueue 都塞不下了,就执行拒绝策略。可以自定义,用来重试任务,默认是直接丢掉。JDK 提供了 4 种。the handler to use when execution is blocked because the thread bounds and queue capacities are reached

ThreadPoolExecutor 允许提供一个 Blocking Queue 来保存等待执行的任务。

无界队列。LinkedBlockingQueue 默认的构造器就是无界的。public LinkedBlockingQueue() { this(Integer.MAX_VALUE);}

有界队列。ArrayBlockingQueue、有界的 LinkedBlockingQueue、PriorityBlockingQueue。

同步移交。Synchronous Handoff。

无界队列将不会执行拒绝策略,当然如果你的线程数大于了 Integer.MAX_VALUE 还是会执行的,前提是你到达这么多。一般情况就 OOM 了。所以《阿里巴巴 Java 开发规范》中不使用 Executors 创建线城池。

饱和策略

AbortPolicy:中止策略是默认的饱和策略,该策略将抛出未检查的 RejectedExecutionException 调用者可以捕获这个异常,然后根据需求编写自己的处理代码。

DiscardPolicy:当新提交的任务无法保存到队列中等待执行时,抛弃策略会悄悄抛弃该任务。

CallerRunsPolicy:调用者运行(Caller-Runs)策略实现了一种调节机制,该策略既不会抛弃任务,也不会抛弃异常,而是将某些任务回退到调用者,从而降低新任务的流量。它不会在线程池的某个线程中执行新提交的任务,而是在一个调用了 execute 的线程中执行该任务。

DiscardOldestPolicy:抛弃最旧的(Discard-Oldest)策略则会抛弃下一个将被执行的任务,然后尝试重新提交新的任务。如果工作队列是一个优先队列,那么”抛弃最旧的“策略将导致抛弃优先级最高的任务,因此最好不要将“抛弃最旧的”饱和策略和优先级队列放在一起使用。

SynchronousQueue 对于非常大的或者无界的线程池,可以通过使用 SynchronousQueue 来避免任务排队,以及直接将任务从生产者移交给工作者线程。SynchronousQueque 不是一个真正的队列,而是一种在线程之间进行移交的机制。要将一个元素放入 SynchronousQueue 中,必须有另一个线程正在等待接受这个元素。如果没有线程正在等待,并且线程池的当前大小小于最大值,那么 ThreadPoolExecutor 将创建一个新的线程,否则根据饱和策略,这个任务将被拒绝。

ThreadFactory 许多情况下都需要使用定制的线程工厂方法。

例如,为线程池中的线程制定一个 UncaughtExceptionHandler,或者实例化一个定制的 Thread 类用于执行调试信息的记录。线程优先级(其实执行的时候优先级只是个参考),或者守护状态(也不建议),最常用的其实就是取个名字 。

Pivatol 团队就封装了个 NamedThreadFactory,简单的封装,简单的应用。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 package io.micrometer.core.instrument.util;public class NamedThreadFactory implements ThreadFactory private final AtomicInteger sequence = new AtomicInteger(1 ); private final String prefix; public NamedThreadFactory (String prefix) this .prefix = prefix; } public Thread newThread (Runnable r) Thread thread = new Thread(r); int seq = this .sequence.getAndIncrement(); thread.setName(this .prefix + (seq > 1 ? "-" + seq : "" )); if (!thread.isDaemon()) { thread.setDaemon(true ); } return thread; } }

SpringBoot 相关的监控解决方案从 SpringBoot 2.0开始全面更改为Micrometer,不过要知道 Micrometer 与 Spring 属于同门,都是Pivotal旗下的产品。

扩展 ThreadPoolexecutor

beforeExecute

afterExecutor

terminated

添加日志、计时、监视或统计信息收集的功能。无论任务是从 run 中正常返回,还是抛出一个异常而返回,afterExecute 都会被调用。如果是一个 Error 就不会。如果 beforeExecute 抛出一个 RuntimeException,那么任务将不被执行,并且 afterExecute 也不会被调用。

在线程池完成关闭操作时调用 terminated,也就是在所有任务都已经完成并且所有工作者线程也已经关闭后。terminated 可以用来释放Executor 在其生命周期里分配的各种资源,此外还可以执行发送通知、记录日志或者收集 finalize 统计信息等操作。

Servlet 容器 Tomcat Jetty Websphere Application Server IBM

Nginx Nginx 服务器 Nginx 集群搭建 引入虚拟 IP,keepalived

MySQL MySQL 执行过程 那些索引 Spring Spring Bean 的加载过程 Spring Bean 元信息配置阶段

基于 XML、Properties 配置

XMLBeanDefinitionReader#loadBeanDefinitions(String resourceUrl);

BeanDefinitionReader 的实现类 AbstractBeanDefinitionReader,而 AbstractBeanDefinitionReader 有三个实现类。分别对应 XML、Properties、Groovy 文件读取方式。现在都不推荐用这几个。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 package org.springframework.beans.factory.support;import org.springframework.beans.factory.BeanDefinitionStoreException;import org.springframework.core.io.Resource;import org.springframework.core.io.ResourceLoader;import org.springframework.lang.Nullable;public interface BeanDefinitionReader BeanDefinitionRegistry getRegistry () ; @Nullable ResourceLoader getResourceLoader () ; @Nullable ClassLoader getBeanClassLoader () ; BeanNameGenerator getBeanNameGenerator () ; int loadBeanDefinitions (Resource var1) throws BeanDefinitionStoreException int loadBeanDefinitions (Resource... var1) throws BeanDefinitionStoreException int loadBeanDefinitions (String var1) throws BeanDefinitionStoreException int loadBeanDefinitions (String... var1) throws BeanDefinitionStoreException } public abstract class AbstractBeanDefinitionReader implements BeanDefinitionReader , EnvironmentCapable protected final Log logger = LogFactory.getLog(this .getClass()); private final BeanDefinitionRegistry registry; @Nullable private ResourceLoader resourceLoader; @Nullable private ClassLoader beanClassLoader; private Environment environment; private BeanNameGenerator beanNameGenerator = new DefaultBeanNameGenerator(); protected AbstractBeanDefinitionReader (BeanDefinitionRegistry registry) Assert.notNull(registry, "BeanDefinitionRegistry must not be null" ); this .registry = registry; if (this .registry instanceof ResourceLoader) { this .resourceLoader = (ResourceLoader)this .registry; } else { this .resourceLoader = new PathMatchingResourcePatternResolver(); } if (this .registry instanceof EnvironmentCapable) { this .environment = ((EnvironmentCapable)this .registry).getEnvironment(); } else { this .environment = new StandardEnvironment(); } } public int loadBeanDefinitions (Resource... resources) throws BeanDefinitionStoreException Assert.notNull(resources, "Resource array must not be null" ); int count = 0 ; Resource[] var3 = resources; int var4 = resources.length; for (int var5 = 0 ; var5 < var4; ++var5) { Resource resource = var3[var5]; count += this .loadBeanDefinitions((Resource)resource); } return count; } public int loadBeanDefinitions (String location) throws BeanDefinitionStoreException return this .loadBeanDefinitions(location, (Set)null ); } public int loadBeanDefinitions (String location, @Nullable Set<Resource> actualResources) throws BeanDefinitionStoreException ResourceLoader resourceLoader = this .getResourceLoader(); if (resourceLoader == null ) { throw new BeanDefinitionStoreException("Cannot load bean definitions from location [" + location + "]: no ResourceLoader available" ); } else { int count; if (resourceLoader instanceof ResourcePatternResolver) { try { Resource[] resources = ((ResourcePatternResolver)resourceLoader).getResources(location); count = this .loadBeanDefinitions(resources); if (actualResources != null ) { Collections.addAll(actualResources, resources); } if (this .logger.isTraceEnabled()) { this .logger.trace("Loaded " + count + " bean definitions from location pattern [" + location + "]" ); } return count; } catch (IOException var6) { throw new BeanDefinitionStoreException("Could not resolve bean definition resource pattern [" + location + "]" , var6); } } else { Resource resource = resourceLoader.getResource(location); count = this .loadBeanDefinitions((Resource)resource); if (actualResources != null ) { actualResources.add(resource); } if (this .logger.isTraceEnabled()) { this .logger.trace("Loaded " + count + " bean definitions from location [" + location + "]" ); } return count; } } } public int loadBeanDefinitions (String... locations) throws BeanDefinitionStoreException Assert.notNull(locations, "Location array must not be null" ); int count = 0 ; String[] var3 = locations; int var4 = locations.length; for (int var5 = 0 ; var5 < var4; ++var5) { String location = var3[var5]; count += this .loadBeanDefinitions(location); } return count; } }

1 public void registerBeanDefinition (String beanName, BeanDefinition beanDefinition) throws BeanDefinitionStoreException

一般是这个 GenericBeanDefinition 类,不管你是什么类,在我这,都叫 BeanDefinition ,而且在后面会有个 Merge 过程,将所有 BeanDefinition 再次转换成 RootBeanDefinition 然后命名为 mbd 进行各种操作。

Spring Bean 元信息解析阶段

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 public class AnnotatedBeanDefinitionReader private final BeanDefinitionRegistry registry; private BeanNameGenerator beanNameGenerator; private ScopeMetadataResolver scopeMetadataResolver; private ConditionEvaluator conditionEvaluator; public AnnotatedBeanDefinitionReader (BeanDefinitionRegistry registry) this (registry, getOrCreateEnvironment(registry)); } public AnnotatedBeanDefinitionReader (BeanDefinitionRegistry registry, Environment environment) this .beanNameGenerator = new AnnotationBeanNameGenerator(); this .scopeMetadataResolver = new AnnotationScopeMetadataResolver(); Assert.notNull(registry, "BeanDefinitionRegistry must not be null" ); Assert.notNull(environment, "Environment must not be null" ); this .registry = registry; this .conditionEvaluator = new ConditionEvaluator(registry, environment, (ResourceLoader)null ); AnnotationConfigUtils.registerAnnotationConfigProcessors(this .registry); } public void register (Class<?>... annotatedClasses) Class[] var2 = annotatedClasses; int var3 = annotatedClasses.length; for (int var4 = 0 ; var4 < var3; ++var4) { Class<?> annotatedClass = var2[var4]; this .registerBean(annotatedClass); } } public void registerBean (Class<?> annotatedClass) this .doRegisterBean(annotatedClass, (Supplier)null , (String)null , (Class[])null ); } public <T> void registerBean (Class<T> annotatedClass, @Nullable Supplier<T> instanceSupplier) this .doRegisterBean(annotatedClass, instanceSupplier, (String)null , (Class[])null ); } public <T> void registerBean (Class<T> annotatedClass, String name, @Nullable Supplier<T> instanceSupplier) this .doRegisterBean(annotatedClass, instanceSupplier, name, (Class[])null ); } public void registerBean (Class<?> annotatedClass, Class<? extends Annotation>... qualifiers) this .doRegisterBean(annotatedClass, (Supplier)null , (String)null , qualifiers); } public void registerBean (Class<?> annotatedClass, String name, Class<? extends Annotation>... qualifiers) this .doRegisterBean(annotatedClass, (Supplier)null , name, qualifiers); } <T> void doRegisterBean (Class<T> annotatedClass, @Nullable Supplier<T> instanceSupplier, @Nullable String name, @Nullable Class<? extends Annotation>[] qualifiers, BeanDefinitionCustomizer... definitionCustomizers) AnnotatedGenericBeanDefinition abd = new AnnotatedGenericBeanDefinition(annotatedClass); if (!this .conditionEvaluator.shouldSkip(abd.getMetadata())) { abd.setInstanceSupplier(instanceSupplier); ScopeMetadata scopeMetadata = this .scopeMetadataResolver.resolveScopeMetadata(abd); abd.setScope(scopeMetadata.getScopeName()); String beanName = name != null ? name : this .beanNameGenerator.generateBeanName(abd, this .registry); AnnotationConfigUtils.processCommonDefinitionAnnotations(abd); int var10; int var11; if (qualifiers != null ) { Class[] var9 = qualifiers; var10 = qualifiers.length; for (var11 = 0 ; var11 < var10; ++var11) { Class<? extends Annotation> qualifier = var9[var11]; if (Primary.class == qualifier) { abd.setPrimary(true ); } else if (Lazy.class == qualifier) { abd.setLazyInit(true ); } else { abd.addQualifier(new AutowireCandidateQualifier(qualifier)); } } } BeanDefinitionCustomizer[] var13 = definitionCustomizers; var10 = definitionCustomizers.length; for (var11 = 0 ; var11 < var10; ++var11) { BeanDefinitionCustomizer customizer = var13[var11]; customizer.customize(abd); } BeanDefinitionHolder definitionHolder = new BeanDefinitionHolder(abd, beanName); definitionHolder = AnnotationConfigUtils.applyScopedProxyMode(scopeMetadata, definitionHolder, this .registry); BeanDefinitionReaderUtils.registerBeanDefinition(definitionHolder, this .registry); } } }

这里你都用 Java API 方式配置了,一定有 BeanDefition 配置了。

Spring Bean 注册阶段 DefaultListableBeanFactory 实现了 BeanDefinitionRegistry 。它还有其他的实现类,关于 XML 、注解、Groovy、Reactive(响应式的,Josh Long 在 19年推特上有置顶 《Reactive Spring》)、还有其他的 GenericApplicationContext。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 public void registerBeanDefinition (String beanName, BeanDefinition beanDefinition) throws BeanDefinitionStoreException Assert.hasText(beanName, "Bean name must not be empty" ); Assert.notNull(beanDefinition, "BeanDefinition must not be null" ); if (beanDefinition instanceof AbstractBeanDefinition) { try { ((AbstractBeanDefinition)beanDefinition).validate(); } catch (BeanDefinitionValidationException var9) { throw new BeanDefinitionStoreException(beanDefinition.getResourceDescription(), beanName, "Validation of bean definition failed" , var9); } } BeanDefinition existingDefinition = (BeanDefinition)this .beanDefinitionMap.get(beanName); if (existingDefinition != null ) { if (!this .isAllowBeanDefinitionOverriding()) { throw new BeanDefinitionOverrideException(beanName, beanDefinition, existingDefinition); } if (existingDefinition.getRole() < beanDefinition.getRole()) { if (this .logger.isInfoEnabled()) { this .logger.info("Overriding user-defined bean definition for bean '" + beanName + "' with a framework-generated bean definition: replacing [" + existingDefinition + "] with [" + beanDefinition + "]" ); } } else if (!beanDefinition.equals(existingDefinition)) { if (this .logger.isDebugEnabled()) { this .logger.debug("Overriding bean definition for bean '" + beanName + "' with a different definition: replacing [" + existingDefinition + "] with [" + beanDefinition + "]" ); } } else if (this .logger.isTraceEnabled()) { this .logger.trace("Overriding bean definition for bean '" + beanName + "' with an equivalent definition: replacing [" + existingDefinition + "] with [" + beanDefinition + "]" ); } this .beanDefinitionMap.put(beanName, beanDefinition); } else { if (this .hasBeanCreationStarted()) { synchronized (this .beanDefinitionMap) { this .beanDefinitionMap.put(beanName, beanDefinition); List<String> updatedDefinitions = new ArrayList(this .beanDefinitionNames.size() + 1 ); updatedDefinitions.addAll(this .beanDefinitionNames); updatedDefinitions.add(beanName); this .beanDefinitionNames = updatedDefinitions; if (this .manualSingletonNames.contains(beanName)) { Set<String> updatedSingletons = new LinkedHashSet(this .manualSingletonNames); updatedSingletons.remove(beanName); this .manualSingletonNames = updatedSingletons; } } } else { this .beanDefinitionMap.put(beanName, beanDefinition); this .beanDefinitionNames.add(beanName); this .manualSingletonNames.remove(beanName); } this .frozenBeanDefinitionNames = null ; } if (existingDefinition != null || this .containsSingleton(beanName)) { this .resetBeanDefinition(beanName); } }

Spring BeanDefinition 合并阶段

BeanDefinition 合并

父子 BeanDefinition 合并

当前 BeanFactory 查找

层次性 BeanFactory 查找

1 2 3 4 5 6 7 8 9 public abstract class AbstractBeanFactory extends FactoryBeanRegistrySupport implements ConfigurableBeanFactory @Override public BeanDefinition getMergedBeanDefinition (String name) throws BeansException String beanName = this .transformedBeanName(name); return (BeanDefinition)(!this .containsBeanDefinition(beanName) && this .getParentBeanFactory() instanceof ConfigurableBeanFactory ? ((ConfigurableBeanFactory)this .getParentBeanFactory()).getMergedBeanDefinition(beanName) : this .getMergedLocalBeanDefinition(beanName)); } }

一般的 BeanDefinition 是从 GenericBeanDefinition 转换成 RootBeanDefinition。子的 BeanDeifinition 去合并(merge)父的 BeanDefinition 相关配置。

Spring Bean Class 加载阶段 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179 180 181 182 183 184 185 186 187 188 189 190 191 192 193 194 195 196 197 198 199 200 201 202 203 204 205 206 207 208 209 210 211 212 213 214 215 216 217 218 219 220 221 222 223 224 225 226 227 228 229 230 231 232 233 234 235 236 237 238 239 240 241 242 243 244 245 246 247 248 249 250 251 252 253 254 255 256 257 258 259 260 261 262 263 264 265 266 267 268 269 270 271 272 273 274 275 276 277 278 279 280 281 282 283 284 285 286 287 288 289 290 291 292 293 294 295 296 297 298 299 300 301 302 303 304 305 306 307 308 309 310 311 312 313 314 315 316 317 318 319 320 321 322 323 324 325 326 327 328 329 330 331 332 333 334 335 336 337 338 339 340 341 342 343 344 345 346 347 348 349 350 351 352 353 protected <T> T doGetBean (String name, @Nullable Class<T> requiredType, @Nullable Object[] args, boolean typeCheckOnly) throws BeansException { String beanName = this .transformedBeanName(name); Object sharedInstance = this .getSingleton(beanName); Object bean; if (sharedInstance != null && args == null ) { if (this .logger.isTraceEnabled()) { if (this .isSingletonCurrentlyInCreation(beanName)) { this .logger.trace("Returning eagerly cached instance of singleton bean '" + beanName + "' that is not fully initialized yet - a consequence of a circular reference" ); } else { this .logger.trace("Returning cached instance of singleton bean '" + beanName + "'" ); } } bean = this .getObjectForBeanInstance(sharedInstance, name, beanName, (RootBeanDefinition)null ); } else { if (this .isPrototypeCurrentlyInCreation(beanName)) { throw new BeanCurrentlyInCreationException(beanName); } BeanFactory parentBeanFactory = this .getParentBeanFactory(); if (parentBeanFactory != null && !this .containsBeanDefinition(beanName)) { String nameToLookup = this .originalBeanName(name); if (parentBeanFactory instanceof AbstractBeanFactory) { return ((AbstractBeanFactory)parentBeanFactory).doGetBean(nameToLookup, requiredType, args, typeCheckOnly); } if (args != null ) { return parentBeanFactory.getBean(nameToLookup, args); } if (requiredType != null ) { return parentBeanFactory.getBean(nameToLookup, requiredType); } return parentBeanFactory.getBean(nameToLookup); } if (!typeCheckOnly) { this .markBeanAsCreated(beanName); } try { RootBeanDefinition mbd = this .getMergedLocalBeanDefinition(beanName); this .checkMergedBeanDefinition(mbd, beanName, args); String[] dependsOn = mbd.getDependsOn(); String[] var11; if (dependsOn != null ) { var11 = dependsOn; int var12 = dependsOn.length; for (int var13 = 0 ; var13 < var12; ++var13) { String dep = var11[var13]; if (this .isDependent(beanName, dep)) { throw new BeanCreationException(mbd.getResourceDescription(), beanName, "Circular depends-on relationship between '" + beanName + "' and '" + dep + "'" ); } this .registerDependentBean(dep, beanName); try { this .getBean(dep); } catch (NoSuchBeanDefinitionException var24) { throw new BeanCreationException(mbd.getResourceDescription(), beanName, "'" + beanName + "' depends on missing bean '" + dep + "'" , var24); } } } if (mbd.isSingleton()) { sharedInstance = this .getSingleton(beanName, () -> { try { return this .createBean(beanName, mbd, args); } catch (BeansException var5) { this .destroySingleton(beanName); throw var5; } }); bean = this .getObjectForBeanInstance(sharedInstance, name, beanName, mbd); } else if (mbd.isPrototype()) { var11 = null ; Object prototypeInstance; try { this .beforePrototypeCreation(beanName); prototypeInstance = this .createBean(beanName, mbd, args); } finally { this .afterPrototypeCreation(beanName); } bean = this .getObjectForBeanInstance(prototypeInstance, name, beanName, mbd); } else { String scopeName = mbd.getScope(); Scope scope = (Scope)this .scopes.get(scopeName); if (scope == null ) { throw new IllegalStateException("No Scope registered for scope name '" + scopeName + "'" ); } try { Object scopedInstance = scope.get(beanName, () -> { this .beforePrototypeCreation(beanName); Object var4; try { var4 = this .createBean(beanName, mbd, args); } finally { this .afterPrototypeCreation(beanName); } return var4; }); bean = this .getObjectForBeanInstance(scopedInstance, name, beanName, mbd); } catch (IllegalStateException var23) { throw new BeanCreationException(beanName, "Scope '" + scopeName + "' is not active for the current thread; consider defining a scoped proxy for this bean if you intend to refer to it from a singleton" , var23); } } } catch (BeansException var26) { this .cleanupAfterBeanCreationFailure(beanName); throw var26; } } if (requiredType != null && !requiredType.isInstance(bean)) { try { T convertedBean = this .getTypeConverter().convertIfNecessary(bean, requiredType); if (convertedBean == null ) { throw new BeanNotOfRequiredTypeException(name, requiredType, bean.getClass()); } else { return convertedBean; } } catch (TypeMismatchException var25) { if (this .logger.isTraceEnabled()) { this .logger.trace("Failed to convert bean '" + name + "' to required type '" + ClassUtils.getQualifiedName(requiredType) + "'" , var25); } throw new BeanNotOfRequiredTypeException(name, requiredType, bean.getClass()); } } else { return bean; } } public Object getSingleton (String beanName, ObjectFactory<?> singletonFactory) Assert.notNull(beanName, "Bean name must not be null" ); synchronized (this .singletonObjects) { Object singletonObject = this .singletonObjects.get(beanName); if (singletonObject == null ) { if (this .singletonsCurrentlyInDestruction) { throw new BeanCreationNotAllowedException(beanName, "Singleton bean creation not allowed while singletons of this factory are in destruction (Do not request a bean from a BeanFactory in a destroy method implementation!)" ); } if (this .logger.isDebugEnabled()) { this .logger.debug("Creating shared instance of singleton bean '" + beanName + "'" ); } this .beforeSingletonCreation(beanName); boolean newSingleton = false ; boolean recordSuppressedExceptions = this .suppressedExceptions == null ; if (recordSuppressedExceptions) { this .suppressedExceptions = new LinkedHashSet(); } try { singletonObject = singletonFactory.getObject(); newSingleton = true ; } catch (IllegalStateException var16) { singletonObject = this .singletonObjects.get(beanName); if (singletonObject == null ) { throw var16; } } catch (BeanCreationException var17) { BeanCreationException ex = var17; if (recordSuppressedExceptions) { Iterator var8 = this .suppressedExceptions.iterator(); while (var8.hasNext()) { Exception suppressedException = (Exception)var8.next(); ex.addRelatedCause(suppressedException); } } throw ex; } finally { if (recordSuppressedExceptions) { this .suppressedExceptions = null ; } this .afterSingletonCreation(beanName); } if (newSingleton) { this .addSingleton(beanName, singletonObject); } } return singletonObject; } } protected Object createBean (String beanName, RootBeanDefinition mbd, @Nullable Object[] args) throws BeanCreationException if (this .logger.isTraceEnabled()) { this .logger.trace("Creating instance of bean '" + beanName + "'" ); } RootBeanDefinition mbdToUse = mbd; Class<?> resolvedClass = this .resolveBeanClass(mbd, beanName, new Class[0 ]); if (resolvedClass != null && !mbd.hasBeanClass() && mbd.getBeanClassName() != null ) { mbdToUse = new RootBeanDefinition(mbd); mbdToUse.setBeanClass(resolvedClass); } try { mbdToUse.prepareMethodOverrides(); } catch (BeanDefinitionValidationException var9) { throw new BeanDefinitionStoreException(mbdToUse.getResourceDescription(), beanName, "Validation of method overrides failed" , var9); } Object beanInstance; try { beanInstance = this .resolveBeforeInstantiation(beanName, mbdToUse); if (beanInstance != null ) { return beanInstance; } } catch (Throwable var10) { throw new BeanCreationException(mbdToUse.getResourceDescription(), beanName, "BeanPostProcessor before instantiation of bean failed" , var10); } try { beanInstance = this .doCreateBean(beanName, mbdToUse, args); if (this .logger.isTraceEnabled()) { this .logger.trace("Finished creating instance of bean '" + beanName + "'" ); } return beanInstance; } catch (ImplicitlyAppearedSingletonException | BeanCreationException var7) { throw var7; } catch (Throwable var8) { throw new BeanCreationException(mbdToUse.getResourceDescription(), beanName, "Unexpected exception during bean creation" , var8); } } @Nullable protected Class<?> resolveBeanClass(RootBeanDefinition mbd, String beanName, Class<?>... typesToMatch) throws CannotLoadBeanClassException { try { if (mbd.hasBeanClass()) { return mbd.getBeanClass(); } else { return System.getSecurityManager() != null ? (Class)AccessController.doPrivileged(() -> { return this .doResolveBeanClass(mbd, typesToMatch); }, this .getAccessControlContext()) : this .doResolveBeanClass(mbd, typesToMatch); } } catch (PrivilegedActionException var6) { ClassNotFoundException ex = (ClassNotFoundException)var6.getException(); throw new CannotLoadBeanClassException(mbd.getResourceDescription(), beanName, mbd.getBeanClassName(), ex); } catch (ClassNotFoundException var7) { throw new CannotLoadBeanClassException(mbd.getResourceDescription(), beanName, mbd.getBeanClassName(), var7); } catch (LinkageError var8) { throw new CannotLoadBeanClassException(mbd.getResourceDescription(), beanName, mbd.getBeanClassName(), var8); } } private Class<?> doResolveBeanClass(RootBeanDefinition mbd, Class<?>... typesToMatch) throws ClassNotFoundException { ClassLoader beanClassLoader = this .getBeanClassLoader(); ClassLoader dynamicLoader = beanClassLoader; boolean freshResolve = false ; if (!ObjectUtils.isEmpty(typesToMatch)) { ClassLoader tempClassLoader = this .getTempClassLoader(); if (tempClassLoader != null ) { dynamicLoader = tempClassLoader; freshResolve = true ; if (tempClassLoader instanceof DecoratingClassLoader) { DecoratingClassLoader dcl = (DecoratingClassLoader)tempClassLoader; Class[] var8 = typesToMatch; int var9 = typesToMatch.length; for (int var10 = 0 ; var10 < var9; ++var10) { Class<?> typeToMatch = var8[var10]; dcl.excludeClass(typeToMatch.getName()); } } } } String className = mbd.getBeanClassName(); if (className != null ) { Object evaluated = this .evaluateBeanDefinitionString(className, mbd); if (!className.equals(evaluated)) { if (evaluated instanceof Class) { return (Class)evaluated; } if (!(evaluated instanceof String)) { throw new IllegalStateException("Invalid class name expression result: " + evaluated); } className = (String)evaluated; freshResolve = true ; } if (freshResolve) { if (dynamicLoader != null ) { try { return dynamicLoader.loadClass(className); } catch (ClassNotFoundException var12) { if (this .logger.isTraceEnabled()) { this .logger.trace("Could not load class [" + className + "] from " + dynamicLoader + ": " + var12); } } } return ClassUtils.forName(className, dynamicLoader); } } return mbd.resolveBeanClass(beanClassLoader); } @Nullable public Class<?> resolveBeanClass(@Nullable ClassLoader classLoader) throws ClassNotFoundException { String className = this .getBeanClassName(); if (className == null ) { return null ; } else { Class<?> resolvedClass = ClassUtils.forName(className, classLoader); this .beanClass = resolvedClass; return resolvedClass; } }

至此 BeanDefinition 变成 Class 的操作已经结束。一般情况下,就是利用 加载 BeanFactory 的ClassLoader来加载,只是多了个 Java 安全的校验加载。

Spring Bean 实例化前阶段 主要是下面这个接口,在Spring 5前面有个Adpter类,就是和 WebMvcConfigurerAdapter 一样,为了适配之后的类。继承这个接口,实现 postProcessBeforeInstantiation 方法,就可以对 Bean 实例化前进行操作。增强事务功能就是对这个方法进行了改造。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179 180 181 182 183 184 185 186 187 188 189 190 191 192 193 194 195 196 197 198 199 200 201 202 203 204 205 206 207 208 209 210 211 212 213 214 215 216 217 218 219 220 221 222 223 224 225 226 227 228 229 230 231 232 233 234 235 236 237 238 239 240 241 242 243 244 245 246 247 248 249 250 251 252 253 254 255 256 257 258 259 260 261 262 263 264 265 266 267 268 269 270 271 272 273 274 275 276 277 278 279 280 281 282 283 284 285 286 287 288 289 290 291 292 293 294 295 296 297 298 299 300 301 302 303 304 305 306 307 308 309 310 311 312 313 314 315 316 317 318 319 320 321 322 323 324 325 326 327 328 329 330 public interface InstantiationAwareBeanPostProcessor extends BeanPostProcessor @Nullable default Object postProcessBeforeInstantiation (Class<?> beanClass, String beanName) throws BeansException return null ; } default boolean postProcessAfterInstantiation (Object bean, String beanName) throws BeansException return true ; } @Nullable default PropertyValues postProcessProperties (PropertyValues pvs, Object bean, String beanName) throws BeansException return null ; } @Deprecated @Nullable default PropertyValues postProcessPropertyValues (PropertyValues pvs, PropertyDescriptor[] pds, Object bean, String beanName) throws BeansException return pvs; } } protected Object createBean (String beanName, RootBeanDefinition mbd, @Nullable Object[] args) throws BeanCreationException if (this .logger.isTraceEnabled()) { this .logger.trace("Creating instance of bean '" + beanName + "'" ); } RootBeanDefinition mbdToUse = mbd; Class<?> resolvedClass = this .resolveBeanClass(mbd, beanName, new Class[0 ]); if (resolvedClass != null && !mbd.hasBeanClass() && mbd.getBeanClassName() != null ) { mbdToUse = new RootBeanDefinition(mbd); mbdToUse.setBeanClass(resolvedClass); } try { mbdToUse.prepareMethodOverrides(); } catch (BeanDefinitionValidationException var9) { throw new BeanDefinitionStoreException(mbdToUse.getResourceDescription(), beanName, "Validation of method overrides failed" , var9); } Object beanInstance; try { beanInstance = this .resolveBeforeInstantiation(beanName, mbdToUse); if (beanInstance != null ) { return beanInstance; } } catch (Throwable var10) { throw new BeanCreationException(mbdToUse.getResourceDescription(), beanName, "BeanPostProcessor before instantiation of bean failed" , var10); } try { beanInstance = this .doCreateBean(beanName, mbdToUse, args); if (this .logger.isTraceEnabled()) { this .logger.trace("Finished creating instance of bean '" + beanName + "'" ); } return beanInstance; } catch (ImplicitlyAppearedSingletonException | BeanCreationException var7) { throw var7; } catch (Throwable var8) { throw new BeanCreationException(mbdToUse.getResourceDescription(), beanName, "Unexpected exception during bean creation" , var8); } } @Nullable protected Object resolveBeforeInstantiation (String beanName, RootBeanDefinition mbd) Object bean = null ; if (!Boolean.FALSE.equals(mbd.beforeInstantiationResolved)) { if (!mbd.isSynthetic() && this .hasInstantiationAwareBeanPostProcessors()) { Class<?> targetType = this .determineTargetType(beanName, mbd); if (targetType != null ) { bean = this .applyBeanPostProcessorsBeforeInstantiation(targetType, beanName); if (bean != null ) { bean = this .applyBeanPostProcessorsAfterInitialization(bean, beanName); } } } mbd.beforeInstantiationResolved = bean != null ; } return bean; } protected Object doCreateBean (String beanName, RootBeanDefinition mbd, @Nullable Object[] args) throws BeanCreationException BeanWrapper instanceWrapper = null ; if (mbd.isSingleton()) { instanceWrapper = (BeanWrapper)this .factoryBeanInstanceCache.remove(beanName); } if (instanceWrapper == null ) { instanceWrapper = this .createBeanInstance(beanName, mbd, args); } Object bean = instanceWrapper.getWrappedInstance(); Class<?> beanType = instanceWrapper.getWrappedClass(); if (beanType != NullBean.class ) { mbd.resolvedTargetType = beanType; } synchronized (mbd.postProcessingLock) { if (!mbd.postProcessed) { try { this .applyMergedBeanDefinitionPostProcessors(mbd, beanType, beanName); } catch (Throwable var17) { throw new BeanCreationException(mbd.getResourceDescription(), beanName, "Post-processing of merged bean definition failed" , var17); } mbd.postProcessed = true ; } } boolean earlySingletonExposure = mbd.isSingleton() && this .allowCircularReferences && this .isSingletonCurrentlyInCreation(beanName); if (earlySingletonExposure) { if (this .logger.isTraceEnabled()) { this .logger.trace("Eagerly caching bean '" + beanName + "' to allow for resolving potential circular references" ); } this .addSingletonFactory(beanName, () -> { return this .getEarlyBeanReference(beanName, mbd, bean); }); } Object exposedObject = bean; try { this .populateBean(beanName, mbd, instanceWrapper); exposedObject = this .initializeBean(beanName, exposedObject, mbd); } catch (Throwable var18) { if (var18 instanceof BeanCreationException && beanName.equals(((BeanCreationException)var18).getBeanName())) { throw (BeanCreationException)var18; } throw new BeanCreationException(mbd.getResourceDescription(), beanName, "Initialization of bean failed" , var18); } if (earlySingletonExposure) { Object earlySingletonReference = this .getSingleton(beanName, false ); if (earlySingletonReference != null ) { if (exposedObject == bean) { exposedObject = earlySingletonReference; } else if (!this .allowRawInjectionDespiteWrapping && this .hasDependentBean(beanName)) { String[] dependentBeans = this .getDependentBeans(beanName); Set<String> actualDependentBeans = new LinkedHashSet(dependentBeans.length); String[] var12 = dependentBeans; int var13 = dependentBeans.length; for (int var14 = 0 ; var14 < var13; ++var14) { String dependentBean = var12[var14]; if (!this .removeSingletonIfCreatedForTypeCheckOnly(dependentBean)) { actualDependentBeans.add(dependentBean); } } if (!actualDependentBeans.isEmpty()) { throw new BeanCurrentlyInCreationException(beanName, "Bean with name '" + beanName + "' has been injected into other beans [" + StringUtils.collectionToCommaDelimitedString(actualDependentBeans) + "] in its raw version as part of a circular reference, but has eventually been wrapped. This means that said other beans do not use the final version of the bean. This is often the result of over-eager type matching - consider using 'getBeanNamesOfType' with the 'allowEagerInit' flag turned off, for example." ); } } } } try { this .registerDisposableBeanIfNecessary(beanName, bean, mbd); return exposedObject; } catch (BeanDefinitionValidationException var16) { throw new BeanCreationException(mbd.getResourceDescription(), beanName, "Invalid destruction signature" , var16); } } protected void populateBean (String beanName, RootBeanDefinition mbd, @Nullable BeanWrapper bw) if (bw == null ) { if (mbd.hasPropertyValues()) { throw new BeanCreationException(mbd.getResourceDescription(), beanName, "Cannot apply property values to null instance" ); } } else { boolean continueWithPropertyPopulation = true ; if (!mbd.isSynthetic() && this .hasInstantiationAwareBeanPostProcessors()) { Iterator var5 = this .getBeanPostProcessors().iterator(); while (var5.hasNext()) { BeanPostProcessor bp = (BeanPostProcessor)var5.next(); if (bp instanceof InstantiationAwareBeanPostProcessor) { InstantiationAwareBeanPostProcessor ibp = (InstantiationAwareBeanPostProcessor)bp; if (!ibp.postProcessAfterInstantiation(bw.getWrappedInstance(), beanName)) { continueWithPropertyPopulation = false ; break ; } } } } if (continueWithPropertyPopulation) { PropertyValues pvs = mbd.hasPropertyValues() ? mbd.getPropertyValues() : null ; if (mbd.getResolvedAutowireMode() == 1 || mbd.getResolvedAutowireMode() == 2 ) { MutablePropertyValues newPvs = new MutablePropertyValues((PropertyValues)pvs); if (mbd.getResolvedAutowireMode() == 1 ) { this .autowireByName(beanName, mbd, bw, newPvs); } if (mbd.getResolvedAutowireMode() == 2 ) { this .autowireByType(beanName, mbd, bw, newPvs); } pvs = newPvs; } boolean hasInstAwareBpps = this .hasInstantiationAwareBeanPostProcessors(); boolean needsDepCheck = mbd.getDependencyCheck() != 0 ; PropertyDescriptor[] filteredPds = null ; if (hasInstAwareBpps) { if (pvs == null ) { pvs = mbd.getPropertyValues(); } Iterator var9 = this .getBeanPostProcessors().iterator(); while (var9.hasNext()) { BeanPostProcessor bp = (BeanPostProcessor)var9.next(); if (bp instanceof InstantiationAwareBeanPostProcessor) { InstantiationAwareBeanPostProcessor ibp = (InstantiationAwareBeanPostProcessor)bp; PropertyValues pvsToUse = ibp.postProcessProperties((PropertyValues)pvs, bw.getWrappedInstance(), beanName); if (pvsToUse == null ) { if (filteredPds == null ) { filteredPds = this .filterPropertyDescriptorsForDependencyCheck(bw, mbd.allowCaching); } pvsToUse = ibp.postProcessPropertyValues((PropertyValues)pvs, filteredPds, bw.getWrappedInstance(), beanName); if (pvsToUse == null ) { return ; } } pvs = pvsToUse; } } } if (needsDepCheck) { if (filteredPds == null ) { filteredPds = this .filterPropertyDescriptorsForDependencyCheck(bw, mbd.allowCaching); } this .checkDependencies(beanName, mbd, filteredPds, (PropertyValues)pvs); } if (pvs != null ) { this .applyPropertyValues(beanName, mbd, bw, (PropertyValues)pvs); } } } } protected Object initializeBean (String beanName, Object bean, @Nullable RootBeanDefinition mbd) if (System.getSecurityManager() != null ) { AccessController.doPrivileged(() -> { this .invokeAwareMethods(beanName, bean); return null ; }, this .getAccessControlContext()); } else { this .invokeAwareMethods(beanName, bean); } Object wrappedBean = bean; if (mbd == null || !mbd.isSynthetic()) { wrappedBean = this .applyBeanPostProcessorsBeforeInitialization(bean, beanName); } try { this .invokeInitMethods(beanName, wrappedBean, mbd); } catch (Throwable var6) { throw new BeanCreationException(mbd != null ? mbd.getResourceDescription() : null , beanName, "Invocation of init method failed" , var6); } if (mbd == null || !mbd.isSynthetic()) { wrappedBean = this .applyBeanPostProcessorsAfterInitialization(wrappedBean, beanName); } return wrappedBean; } private void invokeAwareMethods (String beanName, Object bean) if (bean instanceof Aware) { if (bean instanceof BeanNameAware) { ((BeanNameAware)bean).setBeanName(beanName); } if (bean instanceof BeanClassLoaderAware) { ClassLoader bcl = this .getBeanClassLoader(); if (bcl != null ) { ((BeanClassLoaderAware)bean).setBeanClassLoader(bcl); } } if (bean instanceof BeanFactoryAware) { ((BeanFactoryAware)bean).setBeanFactory(this ); } } }

Spring Bean 实例化阶段

传统实例化方式

实例化策略 - InstantiationStrategy

构造器依赖注入(这里的一个方法有几百行代码,去验证,加载,如果参数比较多,不建议构造器注入)

实例化就是上面的 doCreateBean 方法。

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179 180 181 182 183 184 185 186 187 188 189 190 191 192 193 194 195 196 197 198 199 200 201 202 203 204 205 206 207 208 209 210 211 212 213 214 215 216 217 218 219 220 221 222 223 224 225 226 227 228 229 230 231 232 233 234 235 236 237 238 239 240 241 242 243 244 245 246 247 248 249 250 251 252 protected Object doCreateBean (String beanName, RootBeanDefinition mbd, @Nullable Object[] args) throws BeanCreationException BeanWrapper instanceWrapper = null ; if (mbd.isSingleton()) { instanceWrapper = (BeanWrapper)this .factoryBeanInstanceCache.remove(beanName); } if (instanceWrapper == null ) { instanceWrapper = this .createBeanInstance(beanName, mbd, args); } Object bean = instanceWrapper.getWrappedInstance(); Class<?> beanType = instanceWrapper.getWrappedClass(); if (beanType != NullBean.class ) { mbd.resolvedTargetType = beanType; } synchronized (mbd.postProcessingLock) { if (!mbd.postProcessed) { try { this .applyMergedBeanDefinitionPostProcessors(mbd, beanType, beanName); } catch (Throwable var17) { throw new BeanCreationException(mbd.getResourceDescription(), beanName, "Post-processing of merged bean definition failed" , var17); } mbd.postProcessed = true ; } } boolean earlySingletonExposure = mbd.isSingleton() && this .allowCircularReferences && this .isSingletonCurrentlyInCreation(beanName); if (earlySingletonExposure) { if (this .logger.isTraceEnabled()) { this .logger.trace("Eagerly caching bean '" + beanName + "' to allow for resolving potential circular references" ); } this .addSingletonFactory(beanName, () -> { return this .getEarlyBeanReference(beanName, mbd, bean); }); } Object exposedObject = bean; try { this .populateBean(beanName, mbd, instanceWrapper); exposedObject = this .initializeBean(beanName, exposedObject, mbd); } catch (Throwable var18) { if (var18 instanceof BeanCreationException && beanName.equals(((BeanCreationException)var18).getBeanName())) { throw (BeanCreationException)var18; } throw new BeanCreationException(mbd.getResourceDescription(), beanName, "Initialization of bean failed" , var18); } if (earlySingletonExposure) { Object earlySingletonReference = this .getSingleton(beanName, false ); if (earlySingletonReference != null ) { if (exposedObject == bean) { exposedObject = earlySingletonReference; } else if (!this .allowRawInjectionDespiteWrapping && this .hasDependentBean(beanName)) { String[] dependentBeans = this .getDependentBeans(beanName); Set<String> actualDependentBeans = new LinkedHashSet(dependentBeans.length); String[] var12 = dependentBeans; int var13 = dependentBeans.length; for (int var14 = 0 ; var14 < var13; ++var14) { String dependentBean = var12[var14]; if (!this .removeSingletonIfCreatedForTypeCheckOnly(dependentBean)) { actualDependentBeans.add(dependentBean); } } if (!actualDependentBeans.isEmpty()) { throw new BeanCurrentlyInCreationException(beanName, "Bean with name '" + beanName + "' has been injected into other beans [" + StringUtils.collectionToCommaDelimitedString(actualDependentBeans) + "] in its raw version as part of a circular reference, but has eventually been wrapped. This means that said other beans do not use the final version of the bean. This is often the result of over-eager type matching - consider using 'getBeanNamesOfType' with the 'allowEagerInit' flag turned off, for example." ); } } } } try { this .registerDisposableBeanIfNecessary(beanName, bean, mbd); return exposedObject; } catch (BeanDefinitionValidationException var16) { throw new BeanCreationException(mbd.getResourceDescription(), beanName, "Invalid destruction signature" , var16); } } protected BeanWrapper createBeanInstance (String beanName, RootBeanDefinition mbd, @Nullable Object[] args) Class<?> beanClass = this .resolveBeanClass(mbd, beanName, new Class[0 ]); if (beanClass != null && !Modifier.isPublic(beanClass.getModifiers()) && !mbd.isNonPublicAccessAllowed()) { throw new BeanCreationException(mbd.getResourceDescription(), beanName, "Bean class isn't public, and non-public access not allowed: " + beanClass.getName()); } else { Supplier<?> instanceSupplier = mbd.getInstanceSupplier(); if (instanceSupplier != null ) { return this .obtainFromSupplier(instanceSupplier, beanName); } else if (mbd.getFactoryMethodName() != null ) { return this .instantiateUsingFactoryMethod(beanName, mbd, args); } else { boolean resolved = false ; boolean autowireNecessary = false ; if (args == null ) { synchronized (mbd.constructorArgumentLock) { if (mbd.resolvedConstructorOrFactoryMethod != null ) { resolved = true ; autowireNecessary = mbd.constructorArgumentsResolved; } } } if (resolved) { return autowireNecessary ? this .autowireConstructor(beanName, mbd, (Constructor[])null , (Object[])null ) : this .instantiateBean(beanName, mbd); } else { Constructor<?>[] ctors = this .determineConstructorsFromBeanPostProcessors(beanClass, beanName); if (ctors == null && mbd.getResolvedAutowireMode() != 3 && !mbd.hasConstructorArgumentValues() && ObjectUtils.isEmpty(args)) { ctors = mbd.getPreferredConstructors(); return ctors != null ? this .autowireConstructor(beanName, mbd, ctors, (Object[])null ) : this .instantiateBean(beanName, mbd); } else { return this .autowireConstructor(beanName, mbd, ctors, args); } } } } } protected BeanWrapper instantiateBean (String beanName, RootBeanDefinition mbd) try { Object beanInstance; if (System.getSecurityManager() != null ) { beanInstance = AccessController.doPrivileged(() -> { return thisx.getInstantiationStrategy().instantiate(mbd, beanName, this ); }, this .getAccessControlContext()); } else { beanInstance = this .getInstantiationStrategy().instantiate(mbd, beanName, this ); } BeanWrapper bw = new BeanWrapperImpl(beanInstance); this .initBeanWrapper(bw); return bw; } catch (Throwable var6) { throw new BeanCreationException(mbd.getResourceDescription(), beanName, "Instantiation of bean failed" , var6); } } public AbstractAutowireCapableBeanFactory () this .instantiationStrategy = new CglibSubclassingInstantiationStrategy(); this .parameterNameDiscoverer = new DefaultParameterNameDiscoverer(); this .allowCircularReferences = true ; this .allowRawInjectionDespiteWrapping = false ; this .ignoredDependencyTypes = new HashSet(); this .ignoredDependencyInterfaces = new HashSet(); this .currentlyCreatedBean = new NamedThreadLocal("Currently created bean" ); this .factoryBeanInstanceCache = new ConcurrentHashMap(); this .factoryMethodCandidateCache = new ConcurrentHashMap(); this .filteredPropertyDescriptorsCache = new ConcurrentHashMap(); this .ignoreDependencyInterface(BeanNameAware.class ) ; this .ignoreDependencyInterface(BeanFactoryAware.class ) ; this .ignoreDependencyInterface(BeanClassLoaderAware.class ) ; } public Object (RootBeanDefinition bd, @Nullable String beanName, BeanFactory owner) if (!bd.hasMethodOverrides()) { Constructor constructorToUse; synchronized (bd.constructorArgumentLock) { constructorToUse = (Constructor)bd.resolvedConstructorOrFactoryMethod; if (constructorToUse == null ) { Class<?> clazz = bd.getBeanClass(); if (clazz.isInterface()) { throw new BeanInstantiationException(clazz, "Specified class is an interface" ); } try { if (System.getSecurityManager() != null ) { clazz.getClass(); constructorToUse = (Constructor)AccessController.doPrivileged(() -> { return clazz.getDeclaredConstructor(); }); } else { constructorToUse = clazz.getDeclaredConstructor(); } bd.resolvedConstructorOrFactoryMethod = constructorToUse; } catch (Throwable var9) { throw new BeanInstantiationException(clazz, "No default constructor found" , var9); } } } return BeanUtils.instantiateClass(constructorToUse, new Object[0 ]); } else { return this .instantiateWithMethodInjection(bd, beanName, owner); } } @Nullable protected Constructor<?>[] determineConstructorsFromBeanPostProcessors(@Nullable Class<?> beanClass, String beanName) throws BeansException { if (beanClass != null && this .hasInstantiationAwareBeanPostProcessors()) { Iterator var3 = this .getBeanPostProcessors().iterator(); while (var3.hasNext()) { BeanPostProcessor bp = (BeanPostProcessor)var3.next(); if (bp instanceof SmartInstantiationAwareBeanPostProcessor) { SmartInstantiationAwareBeanPostProcessor ibp = (SmartInstantiationAwareBeanPostProcessor)bp; Constructor<?>[] ctors = ibp.determineCandidateConstructors(beanClass, beanName); if (ctors != null ) { return ctors; } } } } return null ; }

构造器注入,是按照类型注入。也可以通过 @Qualifier指定

Spring Bean 实例化后阶段 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 114 115 116 117 118 119 120 121 122 123 124 125 126 127 128 129 130 131 132 133 134 135 136 137 138 139 140 141 142 143 144 145 146 147 148 149 150 151 152 153 154 155 156 157 158 159 160 161 162 163 164 165 166 167 168 169 170 171 172 173 174 175 176 177 178 179 180 181 182 183 184 185 186 187 188 189 190 191 192 193 194 195 196 197 198 199 200 201 protected void populateBean (String beanName, RootBeanDefinition mbd, @Nullable BeanWrapper bw) if (bw == null ) { if (mbd.hasPropertyValues()) { throw new BeanCreationException(mbd.getResourceDescription(), beanName, "Cannot apply property values to null instance" ); } } else { boolean continueWithPropertyPopulation = true ; if (!mbd.isSynthetic() && this .hasInstantiationAwareBeanPostProcessors()) { Iterator var5 = this .getBeanPostProcessors().iterator(); while (var5.hasNext()) { BeanPostProcessor bp = (BeanPostProcessor)var5.next(); if (bp instanceof InstantiationAwareBeanPostProcessor) { InstantiationAwareBeanPostProcessor ibp = (InstantiationAwareBeanPostProcessor)bp; if (!ibp.postProcessAfterInstantiation(bw.getWrappedInstance(), beanName)) { continueWithPropertyPopulation = false ; break ; } } } } if (continueWithPropertyPopulation) { PropertyValues pvs = mbd.hasPropertyValues() ? mbd.getPropertyValues() : null ; if (mbd.getResolvedAutowireMode() == 1 || mbd.getResolvedAutowireMode() == 2 ) { MutablePropertyValues newPvs = new MutablePropertyValues((PropertyValues)pvs); if (mbd.getResolvedAutowireMode() == 1 ) { this .autowireByName(beanName, mbd, bw, newPvs); } if (mbd.getResolvedAutowireMode() == 2 ) { this .autowireByType(beanName, mbd, bw, newPvs); } pvs = newPvs; } boolean hasInstAwareBpps = this .hasInstantiationAwareBeanPostProcessors(); boolean needsDepCheck = mbd.getDependencyCheck() != 0 ; PropertyDescriptor[] filteredPds = null ; if (hasInstAwareBpps) { if (pvs == null ) { pvs = mbd.getPropertyValues(); } Iterator var9 = this .getBeanPostProcessors().iterator(); while (var9.hasNext()) { BeanPostProcessor bp = (BeanPostProcessor)var9.next(); if (bp instanceof InstantiationAwareBeanPostProcessor) { InstantiationAwareBeanPostProcessor ibp = (InstantiationAwareBeanPostProcessor)bp; PropertyValues pvsToUse = ibp.postProcessProperties((PropertyValues)pvs, bw.getWrappedInstance(), beanName); if (pvsToUse == null ) { if (filteredPds == null ) { filteredPds = this .filterPropertyDescriptorsForDependencyCheck(bw, mbd.allowCaching); } pvsToUse = ibp.postProcessPropertyValues((PropertyValues)pvs, filteredPds, bw.getWrappedInstance(), beanName); if (pvsToUse == null ) { return ; } } pvs = pvsToUse; } } } if (needsDepCheck) { if (filteredPds == null ) { filteredPds = this .filterPropertyDescriptorsForDependencyCheck(bw, mbd.allowCaching); } this .checkDependencies(beanName, mbd, filteredPds, (PropertyValues)pvs); } if (pvs != null ) { this .applyPropertyValues(beanName, mbd, bw, (PropertyValues)pvs); } } } } @Nullable protected Object resolveBeforeInstantiation (String beanName, RootBeanDefinition mbd) Object bean = null ; if (!Boolean.FALSE.equals(mbd.beforeInstantiationResolved)) { if (!mbd.isSynthetic() && this .hasInstantiationAwareBeanPostProcessors()) { Class<?> targetType = this .determineTargetType(beanName, mbd); if (targetType != null ) { bean = this .applyBeanPostProcessorsBeforeInstantiation(targetType, beanName); if (bean != null ) { bean = this .applyBeanPostProcessorsAfterInitialization(bean, beanName); } } } mbd.beforeInstantiationResolved = bean != null ; } return bean; } protected Object createBean (String beanName, RootBeanDefinition mbd, @Nullable Object[] args) throws BeanCreationException if (this .logger.isTraceEnabled()) { this .logger.trace("Creating instance of bean '" + beanName + "'" ); } RootBeanDefinition mbdToUse = mbd; Class<?> resolvedClass = this .resolveBeanClass(mbd, beanName, new Class[0 ]); if (resolvedClass != null && !mbd.hasBeanClass() && mbd.getBeanClassName() != null ) { mbdToUse = new RootBeanDefinition(mbd); mbdToUse.setBeanClass(resolvedClass); } try { mbdToUse.prepareMethodOverrides(); } catch (BeanDefinitionValidationException var9) { throw new BeanDefinitionStoreException(mbdToUse.getResourceDescription(), beanName, "Validation of method overrides failed" , var9); } Object beanInstance; try { beanInstance = this .resolveBeforeInstantiation(beanName, mbdToUse); if (beanInstance != null ) { return beanInstance; } } catch (Throwable var10) { throw new BeanCreationException(mbdToUse.getResourceDescription(), beanName, "BeanPostProcessor before instantiation of bean failed" , var10); } try { beanInstance = this .doCreateBean(beanName, mbdToUse, args); if (this .logger.isTraceEnabled()) { this .logger.trace("Finished creating instance of bean '" + beanName + "'" ); } return beanInstance; } catch (ImplicitlyAppearedSingletonException | BeanCreationException var7) { throw var7; } catch (Throwable var8) { throw new BeanCreationException(mbdToUse.getResourceDescription(), beanName, "Unexpected exception during bean creation" , var8); } } @Nullable protected Object applyBeanPostProcessorsBeforeInstantiation (Class<?> beanClass, String beanName) Iterator var3 = this .getBeanPostProcessors().iterator(); while (var3.hasNext()) { BeanPostProcessor bp = (BeanPostProcessor)var3.next(); if (bp instanceof InstantiationAwareBeanPostProcessor) { InstantiationAwareBeanPostProcessor ibp = (InstantiationAwareBeanPostProcessor)bp; Object result = ibp.postProcessBeforeInstantiation(beanClass, beanName); if (result != null ) { return result; } } } return null ; } public Object applyBeanPostProcessorsAfterInitialization (Object existingBean, String beanName) throws BeansException Object result = existingBean; Object current; for (Iterator var4 = this .getBeanPostProcessors().iterator(); var4.hasNext(); result = current) { BeanPostProcessor processor = (BeanPostProcessor)var4.next(); current = processor.postProcessAfterInitialization(result, beanName); if (current == null ) { return result; } } return result; }

也就是为保证 postProcessAfterInitialization 方法一定执行,其实有两处互斥的地方调用了该方法。

Spring Bean 属性赋值前阶段 populateBean 就是属性赋值阶段

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 protected void populateBean (String beanName, RootBeanDefinition mbd, @Nullable BeanWrapper bw) if (bw == null ) { if (mbd.hasPropertyValues()) { throw new BeanCreationException(mbd.getResourceDescription(), beanName, "Cannot apply property values to null instance" ); } } else { boolean continueWithPropertyPopulation = true ; if (!mbd.isSynthetic() && this .hasInstantiationAwareBeanPostProcessors()) { Iterator var5 = this .getBeanPostProcessors().iterator(); while (var5.hasNext()) { BeanPostProcessor bp = (BeanPostProcessor)var5.next(); if (bp instanceof InstantiationAwareBeanPostProcessor) { InstantiationAwareBeanPostProcessor ibp = (InstantiationAwareBeanPostProcessor)bp; if (!ibp.postProcessAfterInstantiation(bw.getWrappedInstance(), beanName)) { continueWithPropertyPopulation = false ; break ; } } } } if (continueWithPropertyPopulation) { PropertyValues pvs = mbd.hasPropertyValues() ? mbd.getPropertyValues() : null ; if (mbd.getResolvedAutowireMode() == 1 || mbd.getResolvedAutowireMode() == 2 ) { MutablePropertyValues newPvs = new MutablePropertyValues((PropertyValues)pvs); if (mbd.getResolvedAutowireMode() == 1 ) { this .autowireByName(beanName, mbd, bw, newPvs); } if (mbd.getResolvedAutowireMode() == 2 ) { this .autowireByType(beanName, mbd, bw, newPvs); } pvs = newPvs; } boolean hasInstAwareBpps = this .hasInstantiationAwareBeanPostProcessors(); boolean needsDepCheck = mbd.getDependencyCheck() != 0 ; PropertyDescriptor[] filteredPds = null ; if (hasInstAwareBpps) { if (pvs == null ) { pvs = mbd.getPropertyValues(); } Iterator var9 = this .getBeanPostProcessors().iterator(); while (var9.hasNext()) { BeanPostProcessor bp = (BeanPostProcessor)var9.next(); if (bp instanceof InstantiationAwareBeanPostProcessor) { InstantiationAwareBeanPostProcessor ibp = (InstantiationAwareBeanPostProcessor)bp; PropertyValues pvsToUse = ibp.postProcessProperties((PropertyValues)pvs, bw.getWrappedInstance(), beanName); if (pvsToUse == null ) { if (filteredPds == null ) { filteredPds = this .filterPropertyDescriptorsForDependencyCheck(bw, mbd.allowCaching); } pvsToUse = ibp.postProcessPropertyValues((PropertyValues)pvs, filteredPds, bw.getWrappedInstance(), beanName); if (pvsToUse == null ) { return ; } } pvs = pvsToUse; } } } if (needsDepCheck) { if (filteredPds == null ) { filteredPds = this .filterPropertyDescriptorsForDependencyCheck(bw, mbd.allowCaching); } this .checkDependencies(beanName, mbd, filteredPds, (PropertyValues)pvs); } if (pvs != null ) { this .applyPropertyValues(beanName, mbd, bw, (PropertyValues)pvs); } } } }

Spring Bean Aware 接口回调阶段 按顺序执行

BeanNameAware

BeanClassLoaderAware